–í –Ĺ–ĺ–≤–ĺ –Ņ—Ä–ĺ—É—á–≤–į–Ĺ–Ķ —Ā–Ķ –Ņ—Ä–Ķ–ī—É–Ņ—Ä–Ķ–∂–ī–į–≤–į, —á–Ķ —Ā–ł—Ā—ā–Ķ–ľ–ł—ā–Ķ —Ā –ł–∑–ļ—É—Ā—ā–≤–Ķ–Ĺ –ł–Ĺ—ā–Ķ–Ľ–Ķ–ļ—ā (–ė–ė) –ľ–ĺ–≥–į—ā –ī–į –Ņ–ĺ–≥—ä–Ľ–Ĺ–į—ā —Ü—Ź–Ľ–ĺ—ā–ĺ —Ā–≤–ĺ–Ī–ĺ–ī–Ĺ–ĺ –∑–Ĺ–į–Ĺ–ł–Ķ –≤ –ł–Ĺ—ā–Ķ—Ä–Ĺ–Ķ—ā –ĺ—Č–Ķ –Ņ—Ä–Ķ–∑ 2026 –≥. –ú–ĺ–ī–Ķ–Ľ–ł—ā–Ķ –Ĺ–į –ł–∑–ļ—É—Ā—ā–≤–Ķ–Ĺ –ł–Ĺ—ā–Ķ–Ľ–Ķ–ļ—ā –ļ–į—ā–ĺ GPT-4, –ļ–ĺ–Ļ—ā–ĺ —É–Ņ—Ä–į–≤–Ľ—Ź–≤–į ChatGPT, –ł–Ľ–ł Claude 3 Opus —Ä–į–∑—á–ł—ā–į—ā –Ĺ–į –ľ–Ĺ–ĺ–≥–ĺ—ā–ĺ —ā—Ä–ł–Ľ–ł–ĺ–Ĺ–ł –ī—É–ľ–ł, —Ā–Ņ–ĺ–ī–Ķ–Ľ–Ķ–Ĺ–ł –ĺ–Ĺ–Ľ–į–Ļ–Ĺ, –∑–į –ī–į —Ā—ā–į–Ĺ–į—ā –Ņ–ĺ-—É–ľ–Ĺ–ł, –Ĺ–ĺ –Ĺ–ĺ–≤–ł—ā–Ķ –Ņ—Ä–ĺ–≥–Ĺ–ĺ–∑–ł —Ā–ĺ—á–į—ā, —á–Ķ —ā–Ķ —Č–Ķ –ł–∑—á–Ķ—Ä–Ņ—Ź—ā –∑–į–Ņ–į—Ā–ł—ā–Ķ –ĺ—ā –Ņ—É–Ī–Ľ–ł—á–Ĺ–ĺ –ī–ĺ—Ā—ā—ä–Ņ–Ĺ–ł –ī–į–Ĺ–Ĺ–ł –Ĺ—Ź–ļ—ä–ī–Ķ –ľ–Ķ–∂–ī—É 2026 –ł 2032 –≥.

–Ę–ĺ–≤–į –ĺ–∑–Ĺ–į—á–į–≤–į, —á–Ķ –∑–į –ī–į —Ā—ä–∑–ī–į–ī–į—ā –Ņ–ĺ-–ī–ĺ–Ī—Ä–ł –ľ–ĺ–ī–Ķ–Ľ–ł, —ā–Ķ—Ö–Ĺ–ĺ–Ľ–ĺ–≥–ł—á–Ĺ–ł—ā–Ķ –ļ–ĺ–ľ–Ņ–į–Ĺ–ł–ł —Č–Ķ —ā—Ä—Ź–Ī–≤–į –ī–į –∑–į–Ņ–ĺ—á–Ĺ–į—ā –ī–į —ā—ä—Ä—Ā—Ź—ā –ī–į–Ĺ–Ĺ–ł –ī—Ä—É–≥–į–ī–Ķ. –Ę–ĺ–≤–į –ľ–ĺ–∂–Ķ –ī–į –≤–ļ–Ľ—é—á–≤–į —Ā—ä–∑–ī–į–≤–į–Ĺ–Ķ –Ĺ–į —Ā–ł–Ĺ—ā–Ķ—ā–ł—á–Ĺ–ł –ī–į–Ĺ–Ĺ–ł, –ĺ–Ī—Ä—ä—Č–į–Ĺ–Ķ –ļ—ä–ľ –ł–∑—ā–ĺ—á–Ĺ–ł—Ü–ł —Ā –Ņ–ĺ-–Ĺ–ł—Ā–ļ–ĺ –ļ–į—á–Ķ—Ā—ā–≤–ĺ –ł–Ľ–ł, –ļ–ĺ–Ķ—ā–ĺ –Ķ –Ņ–ĺ-–ĺ–Ī–Ķ–∑–Ņ–ĺ–ļ–ĺ–ł—ā–Ķ–Ľ–Ĺ–ĺ, –ł–∑–Ņ–ĺ–Ľ–∑–≤–į–Ĺ–Ķ –Ĺ–į —á–į—Ā—ā–Ĺ–ł –ī–į–Ĺ–Ĺ–ł –≤ —Ā—ä—Ä–≤—ä—Ä–ł—ā–Ķ, –ļ–ĺ–ł—ā–ĺ —Ā—ä—Ö—Ä–į–Ĺ—Ź–≤–į—ā —Ā—ä–ĺ–Ī—Č–Ķ–Ĺ–ł—Ź –ł –ł–ľ–Ķ–Ļ–Ľ–ł. –ė–∑—Ā–Ľ–Ķ–ī–ĺ–≤–į—ā–Ķ–Ľ–ł—ā–Ķ —Ā–į –Ņ—É–Ī–Ľ–ł–ļ—É–≤–į–Ľ–ł —Ā–≤–ĺ–ł—ā–Ķ –ĺ—ā–ļ—Ä–ł—ā–ł—Ź –Ĺ–į 4 —é–Ĺ–ł –≤ —Ā—ä—Ä–≤—ä—Ä–į –∑–į –Ņ—Ä–Ķ–ī–Ņ–Ķ—á–į—ā–Ĺ–į –Ņ–ĺ–ī–≥–ĺ—ā–ĺ–≤–ļ–į arXiv.

"–ź–ļ–ĺ —á–į—ā–Ī–ĺ—ā–ĺ–≤–Ķ—ā–Ķ –ļ–ĺ–Ĺ—Ā—É–ľ–ł—Ä–į—ā –≤—Ā–ł—á–ļ–ł –Ĺ–į–Ľ–ł—á–Ĺ–ł –ī–į–Ĺ–Ĺ–ł –ł –Ĺ—Ź–ľ–į –Ņ–ĺ-–Ĺ–į—ā–į—ā—ä—ą–Ķ–Ĺ –Ĺ–į–Ņ—Ä–Ķ–ī—ä–ļ –≤ –Ķ—Ą–Ķ–ļ—ā–ł–≤–Ĺ–ĺ—Ā—ā—ā–į –Ĺ–į –ī–į–Ĺ–Ĺ–ł—ā–Ķ, –Ī–ł—Ö –ĺ—á–į–ļ–≤–į–Ľ –ī–į –Ĺ–į–Ī–Ľ—é–ī–į–≤–į–ľ –ĺ—ā–Ĺ–ĺ—Ā–ł—ā–Ķ–Ľ–Ĺ–į —Ā—ā–į–≥–Ĺ–į—Ü–ł—Ź –≤ –ĺ–Ī–Ľ–į—Ā—ā—ā–į", –ļ–į–∑–≤–į –Ņ—Ä–Ķ–ī Live Science –Ņ—ä—Ä–≤–ł—Ź—ā –į–≤—ā–ĺ—Ä –Ĺ–į –ł–∑—Ā–Ľ–Ķ–ī–≤–į–Ĺ–Ķ—ā–ĺ –ü–į–Ī–Ľ–ĺ –í–ł–Ľ—Ź–Ľ–ĺ–Ī–ĺ—Ā, –ł–∑—Ā–Ľ–Ķ–ī–ĺ–≤–į—ā–Ķ–Ľ –≤ –ł–∑—Ā–Ľ–Ķ–ī–ĺ–≤–į—ā–Ķ–Ľ—Ā–ļ–ł—Ź –ł–Ĺ—Ā—ā–ł—ā—É—ā Epoch AI. "–ú–ĺ–ī–Ķ–Ľ–ł—ā–Ķ —Č–Ķ —Ā–Ķ –Ņ–ĺ–ī–ĺ–Ī—Ä—Ź–≤–į—ā –Ī–į–≤–Ĺ–ĺ —Ā —ā–Ķ—á–Ķ–Ĺ–ł–Ķ –Ĺ–į –≤—Ä–Ķ–ľ–Ķ—ā–ĺ, —ā—ä–Ļ –ļ–į—ā–ĺ —Ā–Ķ –ĺ—ā–ļ—Ä–ł–≤–į—ā –Ĺ–ĺ–≤–ł –į–Ľ–≥–ĺ—Ä–ł—ā–ľ–ł—á–Ĺ–ł –Ņ—Ä–ĺ–∑—Ä–Ķ–Ĺ–ł—Ź –ł –Ķ—Ā—ā–Ķ—Ā—ā–≤–Ķ–Ĺ–ĺ —Ā–Ķ –Ņ—Ä–ĺ–ł–∑–≤–Ķ–∂–ī–į—ā –Ĺ–ĺ–≤–ł –ī–į–Ĺ–Ĺ–ł."

–Ē–į–Ĺ–Ĺ–ł—ā–Ķ –∑–į –ĺ–Ī—É—á–Ķ–Ĺ–ł–Ķ –Ņ–ĺ–ī—Ö—Ä–į–Ĺ–≤–į—ā —Ä–į—Ā—ā–Ķ–∂–į –Ĺ–į —Ā–ł—Ā—ā–Ķ–ľ–ł—ā–Ķ –∑–į –ł–∑–ļ—É—Ā—ā–≤–Ķ–Ĺ –ł–Ĺ—ā–Ķ–Ľ–Ķ–ļ—ā, –ļ–į—ā–ĺ –ł–ľ –Ņ–ĺ–∑–≤–ĺ–Ľ—Ź–≤–į—ā –ī–į –ł–∑–≤–Ľ–ł—á–į—ā –≤—Ā–Ķ –Ņ–ĺ-—Ā–Ľ–ĺ–∂–Ĺ–ł –ľ–ĺ–ī–Ķ–Ľ–ł, –ļ–ĺ–ł—ā–ĺ –ī–į –≤–≥—Ä–į–∂–ī–į—ā –≤ –Ĺ–Ķ–≤—Ä–ĺ–Ĺ–Ĺ–ł—ā–Ķ —Ā–ł –ľ—Ä–Ķ–∂–ł. –Ě–į–Ņ—Ä–ł–ľ–Ķ—Ä ChatGPT –Ķ –ĺ–Ī—É—á–Ķ–Ĺ–į –Ĺ–į –ĺ–ļ–ĺ–Ľ–ĺ 570 GB —ā–Ķ–ļ—Ā—ā–ĺ–≤–ł –ī–į–Ĺ–Ĺ–ł, –ļ–ĺ–ł—ā–ĺ —Ā—ä–ī—ä—Ä–∂–į—ā –ĺ–ļ–ĺ–Ľ–ĺ 300 –ľ–ł–Ľ–ł–į—Ä–ī–į –ī—É–ľ–ł, –≤–∑–Ķ—ā–ł –ĺ—ā –ļ–Ĺ–ł–≥–ł, –ĺ–Ĺ–Ľ–į–Ļ–Ĺ —Ā—ā–į—ā–ł–ł, Wikipedia –ł –ī—Ä—É–≥–ł –ĺ–Ĺ–Ľ–į–Ļ–Ĺ –ł–∑—ā–ĺ—á–Ĺ–ł—Ü–ł.

–ź–Ľ–≥–ĺ—Ä–ł—ā–ľ–ł—ā–Ķ, –ĺ–Ī—É—á–Ķ–Ĺ–ł –≤—ä—Ä—Ö—É –Ĺ–Ķ–ī–ĺ—Ā—ā–į—ā—ä—á–Ĺ–ĺ –ł–Ľ–ł –Ĺ–ł—Ā–ļ–ĺ–ļ–į—á–Ķ—Ā—ā–≤–Ķ–Ĺ–ł –ī–į–Ĺ–Ĺ–ł, –ī–į–≤–į—ā –Ĺ–Ķ—Ā–ł–≥—É—Ä–Ĺ–ł —Ä–Ķ–∑—É–Ľ—ā–į—ā–ł. AI Gemini –Ĺ–į Google, –ļ–ĺ–Ļ—ā–ĺ –Ņ–ĺ–∑–ĺ—Ä–Ĺ–ĺ –Ņ—Ä–Ķ–Ņ–ĺ—Ä—ä—á–į –Ĺ–į —Ö–ĺ—Ä–į—ā–į –ī–į –ī–ĺ–Ī–į–≤—Ź—ā –Ľ–Ķ–Ņ–ł–Ľ–ĺ –ļ—ä–ľ –Ņ–ł—Ü–ł—ā–Ķ —Ā–ł –ł–Ľ–ł –ī–į —Ź–ī–į—ā –ļ–į–ľ—ä–Ĺ–ł, –Ņ–ĺ–Ľ—É—á–ł –Ĺ—Ź–ļ–ĺ–ł –ĺ—ā –ĺ—ā–≥–ĺ–≤–ĺ—Ä–ł—ā–Ķ —Ā–ł –ĺ—ā –Ņ—É–Ī–Ľ–ł–ļ–į—Ü–ł–ł –≤ Reddit –ł —Ā—ā–į—ā–ł–ł –ĺ—ā —Ā–į—ā–ł—Ä–ł—á–Ĺ–ł—Ź —É–Ķ–Ī—Ā–į–Ļ—ā The Onion.

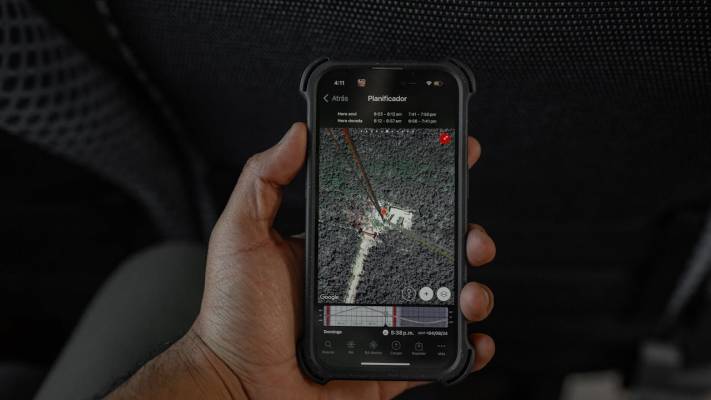

–ó–į –ī–į –Ņ—Ä–Ķ—Ü–Ķ–Ĺ—Ź—ā –ļ–ĺ–Ľ–ļ–ĺ —ā–Ķ–ļ—Ā—ā –ł–ľ–į –≤ –ł–Ĺ—ā–Ķ—Ä–Ĺ–Ķ—ā, –ł–∑—Ā–Ľ–Ķ–ī–ĺ–≤–į—ā–Ķ–Ľ–ł—ā–Ķ –ł–∑–Ņ–ĺ–Ľ–∑–≤–į—ā —É–Ķ–Ī –ł–Ĺ–ī–Ķ–ļ—Ā–į –Ĺ–į Google, –ļ–į—ā–ĺ –ł–∑—á–ł—Ā–Ľ—Ź–≤–į—ā, —á–Ķ –≤ –ľ–ĺ–ľ–Ķ–Ĺ—ā–į –ł–ľ–į –ĺ–ļ–ĺ–Ľ–ĺ 250 –ľ–ł–Ľ–ł–į—Ä–ī–į —É–Ķ–Ī —Ā—ā—Ä–į–Ĺ–ł—Ü–ł, —Ā—ä–ī—ä—Ä–∂–į—Č–ł –Ņ–ĺ 7000 –Ī–į–Ļ—ā–į —ā–Ķ–ļ—Ā—ā –Ĺ–į —Ā—ā—Ä–į–Ĺ–ł—Ü–į. –°–Ľ–Ķ–ī —ā–ĺ–≤–į —Ā–į –ł–∑–Ņ–ĺ–Ľ–∑–≤–į–Ľ–ł –Ņ–ĺ—Ā–Ľ–Ķ–ī–≤–į—Č–ł –į–Ĺ–į–Ľ–ł–∑–ł –Ĺ–į —ā—Ä–į—Ą–ł–ļ–į –Ņ–ĺ –ł–Ĺ—ā–Ķ—Ä–Ĺ–Ķ—ā –Ņ—Ä–ĺ—ā–ĺ–ļ–ĺ–Ľ (IP) - –Ņ–ĺ—ā–ĺ–ļ—ä—ā –ĺ—ā –ī–į–Ĺ–Ĺ–ł –≤ –ľ—Ä–Ķ–∂–į—ā–į - –ł –į–ļ—ā–ł–≤–Ĺ–ĺ—Ā—ā—ā–į –Ĺ–į –Ņ–ĺ—ā—Ä–Ķ–Ī–ł—ā–Ķ–Ľ–ł—ā–Ķ –ĺ–Ĺ–Ľ–į–Ļ–Ĺ, –∑–į –ī–į –Ņ—Ä–ĺ–≥–Ĺ–ĺ–∑–ł—Ä–į—ā –Ĺ–į—Ä–į—Ā—ā–≤–į–Ĺ–Ķ—ā–ĺ –Ĺ–į —ā–ĺ–∑–ł –Ĺ–į–Ľ–ł—á–Ķ–Ĺ –∑–į–Ņ–į—Ā –ĺ—ā –ī–į–Ĺ–Ĺ–ł.

–†–Ķ–∑—É–Ľ—ā–į—ā–ł—ā–Ķ –Ņ–ĺ–ļ–į–∑–į—Ö–į, —á–Ķ –≤–ł—Ā–ĺ–ļ–ĺ–ļ–į—á–Ķ—Ā—ā–≤–Ķ–Ĺ–į—ā–į –ł–Ĺ—Ą–ĺ—Ä–ľ–į—Ü–ł—Ź, –≤–∑–Ķ—ā–į –ĺ—ā –Ĺ–į–ī–Ķ–∂–ī–Ĺ–ł –ł–∑—ā–ĺ—á–Ĺ–ł—Ü–ł, —Č–Ķ –Ī—ä–ī–Ķ –ł–∑—á–Ķ—Ä–Ņ–į–Ĺ–į –Ĺ–į–Ļ-–ļ—ä—Ā–Ĺ–ĺ –ī–ĺ 2032 –≥., –į –Ĺ–ł—Ā–ļ–ĺ–ļ–į—á–Ķ—Ā—ā–≤–Ķ–Ĺ–ł—ā–Ķ –Ķ–∑–ł–ļ–ĺ–≤–ł –ī–į–Ĺ–Ĺ–ł —Č–Ķ –Ī—ä–ī–į—ā –ł–∑—á–Ķ—Ä–Ņ–į–Ĺ–ł –ľ–Ķ–∂–ī—É 2030 –ł 2050 –≥. –ú–Ķ–∂–ī—É–≤—Ä–Ķ–ľ–Ķ–Ĺ–Ĺ–ĺ –ī–į–Ĺ–Ĺ–ł—ā–Ķ –∑–į –ł–∑–ĺ–Ī—Ä–į–∂–Ķ–Ĺ–ł—Ź —Č–Ķ –Ī—ä–ī–į—ā –Ĺ–į–Ņ—ä–Ľ–Ĺ–ĺ –ł–∑—á–Ķ—Ä–Ņ–į–Ĺ–ł –ľ–Ķ–∂–ī—É 2030 –ł 2060 –≥.

–Ē–ĺ–ļ–į–∑–į–Ĺ–ĺ –Ķ, —á–Ķ –Ĺ–Ķ–≤—Ä–ĺ–Ĺ–Ĺ–ł—ā–Ķ –ľ—Ä–Ķ–∂–ł —Ā–Ķ –Ņ–ĺ–ī–ĺ–Ī—Ä—Ź–≤–į—ā –Ņ—Ä–Ķ–ī—Ā–ļ–į–∑—É–Ķ–ľ–ĺ —Ā —É–≤–Ķ–Ľ–ł—á–į–≤–į–Ĺ–Ķ—ā–ĺ –Ĺ–į –Ĺ–į–Ī–ĺ—Ä–ł—ā–Ķ –ĺ—ā –ī–į–Ĺ–Ĺ–ł - —Ź–≤–Ľ–Ķ–Ĺ–ł–Ķ, –Ĺ–į—Ä–Ķ—á–Ķ–Ĺ–ĺ –∑–į–ļ–ĺ–Ĺ –∑–į –Ĺ–Ķ–≤—Ä–ĺ–Ĺ–Ĺ–ĺ—ā–ĺ –ľ–į—Č–į–Ī–ł—Ä–į–Ĺ–Ķ. –°–Ľ–Ķ–ī–ĺ–≤–į—ā–Ķ–Ľ–Ĺ–ĺ –ĺ—Ā—ā–į–≤–į –ĺ—ā–ļ—Ä–ł—ā –≤—ä–Ņ—Ä–ĺ—Ā—ä—ā –ī–į–Ľ–ł –ļ–ĺ–ľ–Ņ–į–Ĺ–ł–ł—ā–Ķ –ľ–ĺ–≥–į—ā –ī–į –Ņ–ĺ–ī–ĺ–Ī—Ä—Ź—ā –Ķ—Ą–Ķ–ļ—ā–ł–≤–Ĺ–ĺ—Ā—ā—ā–į –Ĺ–į –ľ–ĺ–ī–Ķ–Ľ–ł—ā–Ķ, –∑–į –ī–į –ĺ—ā—á–Ķ—ā–į—ā –Ľ–ł–Ņ—Ā–į—ā–į –Ĺ–į –Ĺ–ĺ–≤–ł –ī–į–Ĺ–Ĺ–ł, –ł–Ľ–ł –į–ļ–ĺ –∑–į—ā–≤–ĺ—Ä—Ź—ā –ļ—Ä–į–Ĺ—á–Ķ—ā–ĺ, –Ĺ–į–Ņ—Ä–Ķ–ī—ä–ļ—ä—ā —Č–Ķ —Ā–Ķ –ĺ–ļ–į–∂–Ķ –≤ –∑–į—Ā—ā–ĺ–Ļ.

–í—ä–Ņ—Ä–Ķ–ļ–ł —ā–ĺ–≤–į –í–ł–Ľ—Ź–Ľ–ĺ–Ī–ĺ—Ā –∑–į—Ź–≤–ł, —á–Ķ –ł–∑–≥–Ľ–Ķ–∂–ī–į –ľ–į–Ľ–ļ–ĺ –≤–Ķ—Ä–ĺ—Ź—ā–Ĺ–ĺ –Ĺ–Ķ–ī–ĺ—Ā—ā–ł–≥—ä—ā –Ĺ–į –ī–į–Ĺ–Ĺ–ł –ī–į –Ņ–ĺ–Ņ—Ä–Ķ—á–ł –ī—Ä–į–ľ–į—ā–ł—á–Ĺ–ĺ –Ĺ–į –Ī—ä–ī–Ķ—Č–ĺ—ā–ĺ —Ä–į–∑–≤–ł—ā–ł–Ķ –Ĺ–į –ľ–ĺ–ī–Ķ–Ľ–ł—ā–Ķ –Ĺ–į –ł–∑–ļ—É—Ā—ā–≤–Ķ–Ĺ –ł–Ĺ—ā–Ķ–Ľ–Ķ–ļ—ā.

–°–Ĺ–ł–ľ–ļ–į: Unsplash

–í–ł–∂ –ĺ—Č–Ķ: Arm —É—Ā—ā—Ä–ĺ–Ļ—Ā—ā–≤–į—ā–į —Ā Windows –≤–Ķ—á–Ķ –ľ–ĺ–≥–į—ā –ī–į –Ņ–ĺ–ī–ļ–į—Ä–į—ā –Ĺ–į–ī 1200 –ł–≥—Ä–ł