Миналия вторник Apple показа новите си iPhone-и и обърна специално внимание на вградените LIDAR сензори в Pro моделите. Той би трябвало да осигурява по-добър фокус, особено когато няма много светлинни източници около нас. Той би могъл и да даде началото на нова генерация от по-сложни AR апликации. Нямаше много информация относно как точно ще работи сензорът, но всъщност това не е първото устройство на компанията с LIDAR. Той се появи в новия iPad през март. И въпреки че все още никой не е отварял новите смартфони, за да ги видим отвътре, има предостатъчно такива видеа със споменатия таблет.

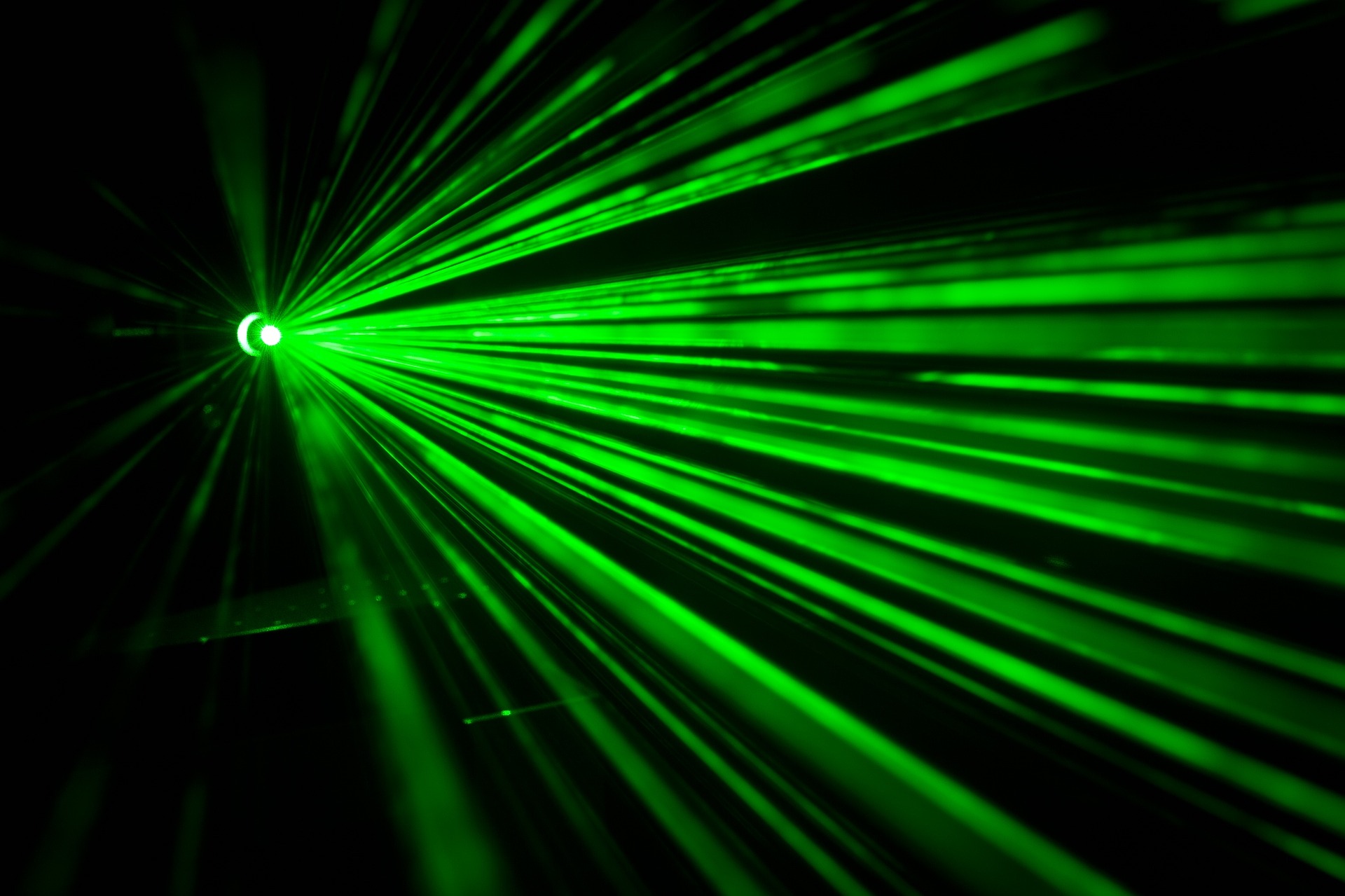

LIDAR сензорите изстрелват лазерен лъч и измерват за колко време ще се отблъсне и върне. Понеже светлината се движи с константна скорост, когато имаме времето, може да бъде изчислено с точност изминатото разстояние. Повтарянето на този процес в двуизмерна среда води до триизмерен „облак от точки“, който отчита на какво разстояние се намират обектите в стаята, на улицата или което място си изберете.

Първият такъв триизмерен сензор е представен от Velodyne преди повече от десетилетие. Устройството тогава струва $75 000 и е осезаемо по-голямо от смартфон. Apple си поставиха за цел да го смалят и поставят в новите си iPhone-и. Тук се намесва VCSEL. Ако искате да си направите лазер, използвайки конвенционални техники за производство на полупроводници, имате две опции. Едната е светлината да се излъчва отстрани на пластината (лазер, излъчващ ръбове), а другата да произлиза от горната ѝ част (лазер, излъчващ вертикална кухина или още известен като VCSEL). Традиционно първият вид са по-мощни. VCSEL се използват от десетилетия в устройства като оптичните мишки. В началото са били считани за недостатъчно силни за дейности, при които е нужно голямо количество светлина, но това се променя с развитието на тази технология.

Направата на лазер, излъчващ ръбове (лазерна показалка например) изисква разрязването на пластината, за да се прояви източникът. Това усложнява и оскъпява процеса на направа, а и ограничава броя лазерни лъчи, които могат да бъдат създадени от една пластина. Противоположно, VCSEL излъчват светлина перпендикулярно на пластината, затова няма нужда тя да бъде разрязвана. Това дава възможност за стотици, дори хиляди лъчи от само един източник. На теория производството на една такава част с хиляди VCSEL лъчи не би трябвало да струва повече от няколко долара.

Първият триизмерен LIDAR от Velodyne съдържа 64 независими един от друг лазери, подредени в колона върху въртящ се гимбъл. Сложността на този дизайн и нуждата всеки лъч да бъде прецизно подравнен е една от причините за високата цена на продукта. От друга страна Apple използва сензори без движещи се части, с хиляди VCSEL лъчи за всяка точка от видимото пространство. Дори предишните модели iPhone имат 3D сензор, наречен TrueDepth камера, който отговаря за FaceID. Според наличната информация той също използва VCSEL лазери, предоставени от Lumentum. TrueDepth проектира решетка от над 30 000 точки върху лицата на потребителите и разпознава чертите им по това, как те я деформират.

LIDAR сензорът в iPad проектира значително по-малко лъчи от тези на TrueDepth камерата. Там решетката е само няколкостотин пиксела. Но не трябва да забравяме, че те имат съвършено различни функции. Единият трябва да разпознае човек по дълбочината на формите на лицето, а другият измерва дистанция, като привежда данните от това, колко време е нужно на лъча да се отблъсне от обектите и да се върне до източника. Този процес би трябвало да дава по-точни резултати, както и да работи на по-дълги разстояния.

Въпреки това (логично) представянето му е много под това на специализираните LIDAR сензори от специализираните в тях компании. В момента най-мощният сензор на Velodyne има обхват от 200 метра, докато този на Apple покрива около 5. Все пак постижението на компанията да успее да намери място за подобна технология в смартфон, без той да струва в пъти повече, е впечатляващо, независимо от гледната точка.

Снимки: Apple; Pixabay

Вижте още: Защо Apple спря да продава iPhone 11 Pro/Pro Max моделите на официалния си сайт?