–Я—А–µ–Ј –њ–Њ—Б–ї–µ–і–љ–Є—В–µ –≥–Њ–і–Є–љ–Є –Ї–Њ–Љ–њ—О—В—К—А–љ–Њ—В–Њ –Ј—А–µ–љ–Є–µ —Б–µ –њ–Њ–і–Њ–±—А–Є –Ј–љ–∞—З–Є—В–µ–ї–љ–Њ, –љ–Њ –≤—Б–µ –Њ—Й–µ –µ –≤ —Б—К—Б—В–Њ—П–љ–Є–µ –і–∞ –љ–∞–њ—А–∞–≤–Є —Б–µ—А–Є–Њ–Ј–љ–Є –≥—А–µ—И–Ї–Є. –Ґ–Њ–ї–Ї–Њ–≤–∞ –Љ–љ–Њ–≥–Њ, —З–µ –Є–Љ–∞ —Ж—П–ї–∞ –Њ–±–ї–∞—Б—В –Њ—В –Є–Ј—Б–ї–µ–і–≤–∞–љ–Є—П, –њ–Њ—Б–≤–µ—В–µ–љ–Є –љ–∞ –Є–Ј—Г—З–∞–≤–∞–љ–µ—В–Њ –љ–∞ –Ї–∞—А—В–Є–љ–Є, –Ї–Њ–Є—В–Њ —А–µ–і–Њ–≤–љ–Њ —Б–∞ –њ–Њ–≥—А–µ—И–љ–Њ –Є–і–µ–љ—В–Є—Д–Є—Ж–Є—А–∞–љ–Є –Њ—В AI, –Є–Ј–≤–µ—Б—В–љ–Є –Ї–∞—В–Њ „–≤—А–∞–ґ–і–µ–±–љ–Є –Њ–±—А–∞–Ј–Є“. –Ь–Є—Б–ї–µ—В–µ –Ј–∞ —В—П—Е –Ї–∞—В–Њ –Ј–∞ –Њ–њ—В–Є—З–љ–Є –Є–ї—О–Ј–Є–Є –Ј–∞ –Ї–Њ–Љ–њ—О—В—А–Є—В–µ. –Ф–Њ–Ї–∞—В–Њ –≤–Є–µ –≤–Є–ґ–і–∞—В–µ –Ї–Њ—В–Ї–∞ –љ–∞ –µ–і–љ–Њ –і—К—А–≤–Њ, AI –≤–Є–ґ–і–∞ –Ї–∞—В–µ—А–Є—Ж–∞.

–Ш–Љ–∞ –≥–Њ–ї—П–Љ–∞ –љ–µ–Њ–±—Е–Њ–і–Є–Љ–Њ—Б—В –Њ—В –Є–Ј—Г—З–∞–≤–∞–љ–µ –љ–∞ —В–µ–Ј–Є –Њ–±—А–∞–Ј–Є. –Ґ—К–є –Ї–∞—В–Њ –њ–Њ—Б—В–∞–≤—П–Љ–µ —Б–Є—Б—В–µ–Љ–Є—В–µ –Ј–∞ –Љ–∞—И–Є–љ–љ–Њ –Ј—А–µ–љ–Є–µ –≤ —Б—К—А—Ж–µ—В–Њ –љ–∞ –љ–Њ–≤–Є—В–µ —В–µ—Е–љ–Њ–ї–Њ–≥–Є–Є –Ї–∞—В–Њ AI –Ї–∞–Љ–µ—А–Є—В–µ –Ј–∞ —Б–Є–≥—Г—А–љ–Њ—Б—В –Є –Ї–Њ–ї–Є—В–µ –Ј–∞ —Б–∞–Љ–Њ—Б—В–Њ—П—В–µ–ї–љ–Њ —И–Њ—Д–Є—А–∞–љ–µ, –≤—П—А–≤–∞–Љ–µ, —З–µ –Ї–Њ–Љ–њ—О—В—А–Є—В–µ –≤–Є–ґ–і–∞—В —Б–≤–µ—В–∞ –њ–Њ —Б—К—Й–Є—П –љ–∞—З–Є–љ, –Ї–∞–Ї—В–Њ –Є –љ–Є–µ. –Т—А–∞–ґ–і–µ–±–љ–Є—В–µ –Њ–±—А–∞–Ј–Є –і–Њ–Ї–∞–Ј–≤–∞—В, —З–µ —В–Њ–≤–∞ –љ–µ–≤–Є–љ–∞–≥–Є –µ —В–∞–Ї–∞.

–Э–Њ –і–Њ–Ї–∞—В–Њ –Љ–љ–Њ–≥–Њ –≤–љ–Є–Љ–∞–љ–Є–µ –≤ —В–∞–Ј–Є –Њ–±–ї–∞—Б—В –µ —Б—К—Б—А–µ–і–Њ—В–Њ—З–µ–љ–Њ –≤—К—А—Е—Г —Б–љ–Є–Љ–Ї–Є, –Ї–Њ–Є—В–Њ —Б–∞ —Б–њ–µ—Ж–Є–∞–ї–љ–Њ –њ—А–µ–і–љ–∞–Ј–љ–∞—З–µ–љ–Є –і–∞ –Ј–∞–±–ї—Г–і—П—В AI (–њ–Њ–і–Њ–±–љ–Њ –љ–∞ 3D –Њ—В–њ–µ—З–∞—В–∞–љ–∞ –Ї–Њ—Б—В–µ–љ—Г—А–Ї–∞, –Ї–Њ—П—В–Њ –∞–ї–≥–Њ—А–Є—В–Љ–Є—В–µ –љ–∞ Google –±—К—А–Ї–∞—В –Ј–∞ –њ–Є—Б—В–Њ–ї–µ—В), —В–µ–Ј–Є –≤–Є–і–Њ–≤–µ –Њ–±—К—А–Ї–≤–∞—Й–Є –≤–Є–Ј—Г–∞–ї–Є–Ј–∞—Ж–Є–Є —Б–µ –њ–Њ—П–≤—П–≤–∞—В –Є –µ—Б—В–µ—Б—В–≤–µ–љ–Њ. –Ґ–∞–Ј–Є –Ї–∞—В–µ–≥–Њ—А–Є—П –Є–Ј–Њ–±—А–∞–ґ–µ–љ–Є—П –µ –њ–Њ-—В—А–µ–≤–Њ–ґ–љ–∞, –Ј–∞—Й–Њ—В–Њ –њ–Њ–Ї–∞–Ј–≤–∞, —З–µ —Б–Є—Б—В–µ–Љ–Є—В–µ –Ј–∞ –Љ–∞—И–Є–љ–љ–Њ –Ј—А–µ–љ–Є–µ –Љ–Њ–≥–∞—В –і–∞ –њ—А–∞–≤—П—В –љ–µ–њ—А–Є–љ—Г–і–µ–љ–Є –≥—А–µ—И–Ї–Є.

–Ч–∞ –і–∞ –і–Њ–Ї–∞–ґ–µ —В–Њ–≤–∞, –≥—А—Г–њ–∞ –Є–Ј—Б–ї–µ–і–Њ–≤–∞—В–µ–ї–Є –Њ—В –С—К—А–Ї–ї–Є, –£–љ–Є–≤–µ—А—Б–Є—В–µ—В–∞ –љ–∞ –Т–∞—И–Є–љ–≥—В–Њ–љ –Є –£–љ–Є–≤–µ—А—Б–Є—В–µ—В–∞ –љ–∞ –І–Є–Ї–∞–≥–Њ —Б—К–Ј–і–∞–≤–∞—В –љ–∞–±–Њ—А –Њ—В –і–∞–љ–љ–Є –Њ—В –Њ–Ї–Њ–ї–Њ 7500 „–µ—Б—В–µ—Б—В–≤–µ–љ–Є –њ—А–Є–Љ–µ—А–Є –Ј–∞ –≤—А–∞–ґ–і–µ–±–љ–Є –Њ–±—А–∞–Ј–Є“. –Ґ–µ —В–µ—Б—В–≤–∞—В —А–µ–і–Є—Ж–∞ —Б–Є—Б—В–µ–Љ–Є –Ј–∞ –Љ–∞—И–Є–љ–љ–Њ –Ј—А–µ–љ–Є–µ —Б —В–µ–Ј–Є –і–∞–љ–љ–Є –Є —Г—Б—В–∞–љ–Њ–≤—П–≤–∞—В, —З–µ —В—П—Е–љ–∞—В–∞ —В–Њ—З–љ–Њ—Б—В –µ —Б–њ–∞–і–љ–∞–ї–∞ —Б –і–Њ 90%, –∞ —Б–Њ—Д—В—Г–µ—А—К—В –≤ –љ—П–Ї–Њ–Є —Б–ї—Г—З–∞–Є –Љ–Њ–ґ–µ –і–∞ –Є–і–µ–љ—В–Є—Д–Є—Ж–Є—А–∞ —Б–∞–Љ–Њ –і–≤–∞ –Є–ї–Є —В—А–Є –њ—А–Њ—Ж–µ–љ—В–∞ –Є–Ј–Њ–±—А–∞–ґ–µ–љ–Є—П.

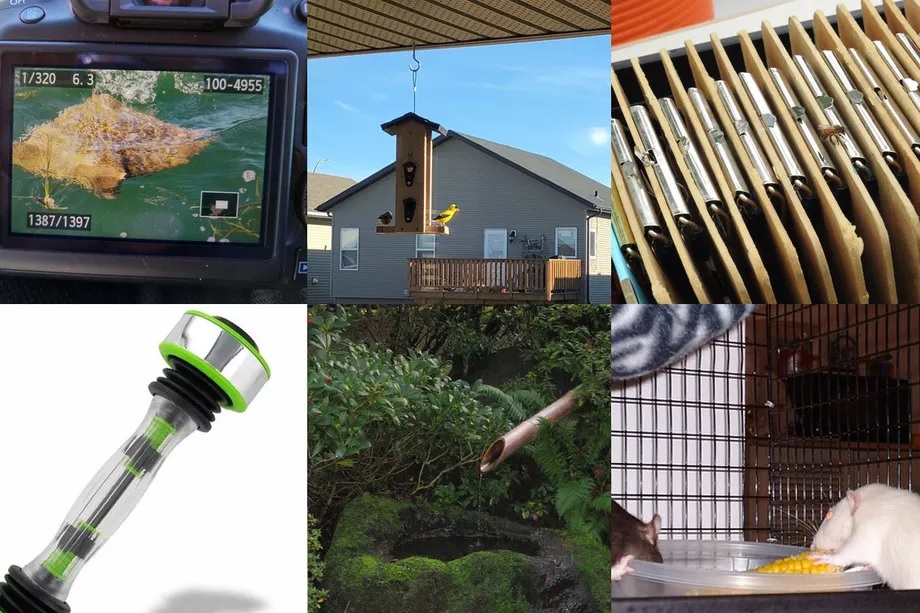

–Ь–Њ–ґ–µ—В–µ –і–∞ –≤–Є–і–Є—В–µ –Ї–∞–Ї –Є–Ј–≥–ї–µ–ґ–і–∞—В —В–µ–Ј–Є „–µ—Б—В–µ—Б—В–≤–µ–љ–Є –њ—А–Є–Љ–µ—А–Є –Ј–∞ –≤—А–∞–ґ–і–µ–±–љ–Є –Њ–±—А–∞–Ј–Є“ –≤ –≥–∞–ї–µ—А–Є—П—В–∞ –њ–Њ-–і–Њ–ї—Г:

–Т –њ—А–Є–і—А—Г–ґ–∞–≤–∞—Й–∞ —Б—В–∞—В–Є—П –Є–Ј—Б–ї–µ–і–Њ–≤–∞—В–µ–ї–Є—В–µ —В–≤—К—А–і—П—В, —З–µ —Б–µ –љ–∞–і—П–≤–∞—В –і–∞–љ–љ–Є—В–µ –і–∞ –њ–Њ–Љ–Њ–≥–љ–∞—В –Ј–∞ –Њ–±—Г—З–µ–љ–Є–µ—В–Њ –љ–∞ –њ–Њ-—Б—В–∞–±–Є–ї–љ–Є —Б–Є—Б—В–µ–Љ–Є –Ј–∞ –Ј—А–µ–љ–Є–µ. –Ґ–µ –Њ–±—П—Б–љ—П–≤–∞—В, —З–µ –Є–Ј–Њ–±—А–∞–ґ–µ–љ–Є—П—В–∞ –Є–Ј–њ–Њ–ї–Ј–≤–∞—В „–і—К–ї–±–Њ–Ї–Є –љ–µ–і–Њ—Б—В–∞—В—К—Ж–Є”, –Ї–Њ–Є—В–Њ –њ—А–Њ–Є–Ј—В–Є—З–∞—В –Њ—В „–њ—А–µ–Ї–∞–ї–µ–љ–Њ—В–Њ —А–∞–Ј—З–Є—В–∞–љ–µ –љ–∞ —Ж–≤–µ—В–∞, —В–µ–Ї—Б—В—Г—А–∞—В–∞ –Є —Д–Њ–љ–Њ–≤–Є—В–µ –Ј–љ–∞—Ж–Є” –љ–∞ —Б–Њ—Д—В—Г–µ—А–∞, –Ј–∞ –і–∞ –Є–і–µ–љ—В–Є—Д–Є—Ж–Є—А–∞ —В–Њ–≤–∞, –Ї–Њ–µ—В–Њ –≤–Є–ґ–і–∞.

–Э—П–Ї–Њ–Є –Є–Ј—Б–ї–µ–і–≤–∞–љ–Є—П –њ–Њ–Ї–∞–Ј–≤–∞—В, —З–µ AI —Б–µ —Д–Њ–Ї—Г—Б–Є—А–∞ –≤—К—А—Е—Г –Ї–Њ–љ–Ї—А–µ—В–љ–Є —В–µ–Ї—Б—В—Г—А–Є –Є –і–µ—В–∞–є–ї–Є, –≤–Љ–µ—Б—В–Њ –і–∞ —А–∞–Ј–≥–ї–µ–ґ–і–∞ —Ж—П–ї–Њ—Б—В–љ–Њ –Ї–∞—А—В–Є–љ–Є—В–µ, –Ї–∞—В–Њ –Є–Љ–∞ –њ—А–µ–і–≤–Є–і –Њ–±—Й–∞—В–∞ —Д–Њ—А–Љ–∞ –Є —Б—К–і—К—А–ґ–∞–љ–Є–µ. –Э–∞–њ—А–Є–Љ–µ—А –≤ –µ–і–љ–Њ –Є–Ј–Њ–±—А–∞–ґ–µ–љ–Є–µ AI –∞–Ї—Ж–µ–љ—В–Є—А–∞ –≤—К—А—Е—Г —Е—А–∞–љ–Є–ї–Ї–∞ –Ј–∞ –Ї–Њ–ї–Є–±—А–Є, –љ–Њ –њ—А–Њ–њ—Г—Б–Ї–∞—В —Д–∞–Ї—В–∞, —З–µ –љ–∞ —Б–љ–Є–Љ–Ї–∞—В–∞ –љ—П–Љ–∞ —Б–∞–Љ–Њ—В–Њ –Ї–Њ–ї–Є–±—А–Є.

–Ґ–Њ–≤–∞, —З–µ —Б–Є—Б—В–µ–Љ–Є—В–µ –Ј–∞ –Є–Ј–Ї—Г—Б—В–≤–µ–љ –Є–љ—В–µ–ї–µ–Ї—В –њ—А–∞–≤—П—В —В–∞–Ї–Є–≤–∞ –≥—А–µ—И–Ї–Є, –љ–µ –µ –љ–Њ–≤–Є–љ–∞. –Ш–Ј—Б–ї–µ–і–Њ–≤–∞—В–µ–ї–Є—В–µ –њ—А–µ–і—Г–њ—А–µ–ґ–і–∞–≤–∞—В –Њ—В –≥–Њ–і–Є–љ–Є, —З–µ —Б–Є—Б—В–µ–Љ–Є—В–µ –Ј–∞ –≤–Є–ґ–і–∞–љ–µ, —Б—К–Ј–і–∞–і–µ–љ–Є —Б –њ–Њ–Љ–Њ—Й—В–∞ –љ–∞ –і—К–ї–±–Њ–Ї–Њ –Њ–±—Г—З–µ–љ–Є–µ (–≤–Є–і –Љ–∞—И–Є–љ–љ–Њ—В–Њ –Њ–±—Г—З–µ–љ–Є–µ, –Ї–Њ–µ—В–Њ –µ –Њ—В–≥–Њ–≤–Њ—А–љ–Њ –Ј–∞ –Љ–љ–Њ–≥–Њ –Њ—В –њ–Њ—Б–ї–µ–і–љ–Є—В–µ –њ–Њ—Б—В–Є–ґ–µ–љ–Є—П –≤ AI), —Б–∞ „–њ–ї–Є—В–Ї–Є“ –Є „—З—Г–њ–ї–Є–≤–Є“ - –Ї–Њ–µ—В–Њ –Њ–Ј–љ–∞—З–∞–≤–∞, —З–µ —В–µ –љ–µ —А–∞–Ј–±–Є—А–∞—В —Б–≤–µ—В–∞ —Б—К—Б —Б—К—Й–Є—П –љ—О–∞–љ—Б –Є –≥—К–≤–Ї–∞–≤–Њ—Б—В –Ї–∞—В–Њ —З–Њ–≤–µ–Ї.

–Ґ–µ–Ј–Є —Б–Є—Б—В–µ–Љ–Є —Б–µ –Њ–±—Г—З–∞–≤–∞—В –љ–∞ —Е–Є–ї—П–і–Є –њ—А–Є–Љ–µ—А–Є, –Ј–∞ –і–∞ –љ–∞—Г—З–∞—В –Ї–∞–Ї –Є–Ј–≥–ї–µ–ґ–і–∞—В –љ–µ—Й–∞—В–∞, –љ–Њ —З–µ—Б—В–Њ –љ–µ –Ј–љ–∞–µ–Љ –Ї–Њ–Є —В–Њ—З–љ–Њ –µ–ї–µ–Љ–µ–љ—В–Є –≤ –Ї–∞—А—В–Є–љ–Є—В–µ –Є–Ј–њ–Њ–ї–Ј–≤–∞ AI, –Ј–∞ –і–∞ –љ–∞–њ—А–∞–≤–Є —Б–≤–Њ–Є—В–µ –њ—А–µ—Ж–µ–љ–Ї–Є.