С усъвършенстването на генеративните системи за изкуствен интелект като ChatGPT на OpenAI и Gemini на Google те все по-често се използват в практиката. Стартъпи и технологични компании изграждат агенти и екосистеми с изкуствен интелект върху системите, които могат да изпълняват скучни задължения вместо вас: помислете за автоматични резервации в календара и потенциално закупуване на продукти. Но тъй като на инструментите се дава повече свобода, се увеличават и потенциалните начини, по които те могат да бъдат атакувани.

Сега, като демонстрация на рисковете от свързаните, автономни екосистеми с изкуствен интелект, група изследователи са създали един от първите според тях генеративни червеи с изкуствен интелект - който може да се разпространява от една система в друга, потенциално крадейки данни или разгръщайки зловреден софтуер в процеса.

"Това по същество означава, че сега имате възможност да провеждате или да извършвате нов вид кибератака, която не е виждана досега", казва Бен Наси, изследовател от Корнелския технологичен институт, който стои зад изследването.

Наси заедно с колегите си изследователи Став Коен и Рон Битън създават червея, наречен Morris II, в знак на почит към оригиналния компютърен червей Morris, който през 1988 г. предизвиква хаос в интернет. В изследователска статия и уебсайт, споделени ексклузивно с WIRED, изследователите показват как червеят може да атакува генеративен имейл асистент с изкуствен интелект, за да открадне данни от имейли и да изпрати спам съобщения - в процеса на работа той нарушава някои защити за сигурност в ChatGPT и Gemini.

Изследването, което е проведено в тестова среда, а не срещу публично достъпен имейл асистент, идва в момент, когато големите езикови модели (LLM) стават все по-мултимодални и могат да генерират изображения и видео, както и текст. Въпреки че генериращите червеи на изкуствения интелект все още не са забелязани в дивата природа, множество изследователи твърдят, че те представляват риск за сигурността, за който стартиращите компании, разработчиците и технологичните компании трябва да се притесняват.

Повечето генеративни системи за изкуствен интелект работят, като им се подават подсказки - текстови инструкции, които казват на инструментите да отговорят на въпрос или да създадат изображение. Тези подсказки обаче могат да бъдат използвани и като оръжие срещу системата. С помощта на джейлбрейкове системата може да пренебрегне правилата си за безопасност и да изхвърли токсично или омразно съдържание, а с атаки за инжектиране на подсказки може да даде на чатбота тайни инструкции. Например нападателят може да скрие текст на уебстраница, който да казва на LLM да действа като измамник и да поиска банковите ви данни.

За да създадат генериращия червей с изкуствен интелект, изследователите се обръщат към така наречената "противникова самовъзпроизвеждаща се подкана". Това е подкана, която задейства генеративния модел на ИИ да изведе в отговор друга подкана, казват изследователите. Накратко, на системата на ИИ се казва да произведе набор от допълнителни инструкции в отговорите си. Това до голяма степен прилича на традиционните атаки с инжектиране на SQL и препълване на буфера, казват изследователите.

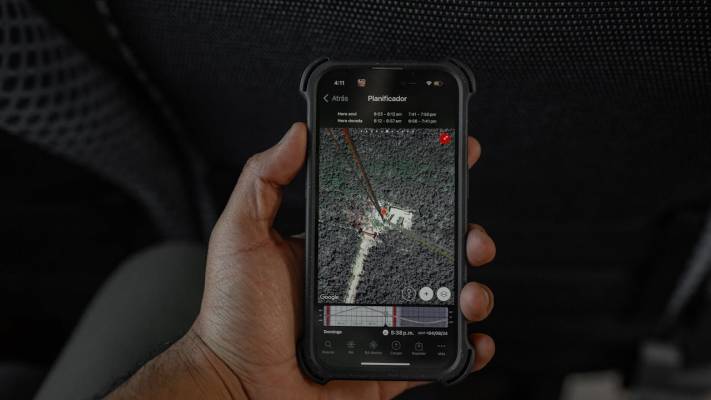

За да покажат как може да работи червеят, изследователите са създали система за електронна поща, която може да изпраща и получава съобщения, използвайки генеративен ИИ, включвайки ChatGPT, Gemini и LLM с отворен код, LLaVA. След това са открили два начина за използване на системата - чрез използване на текстова самовъзпроизвеждаща се подкана и чрез вграждане на самовъзпроизвеждаща се подкана във файл с изображение.

Снимка: Unsplash

Виж още: Neuralink е провалът на Илон Мъск, за който той не иска да разберете