–ü–ĺ-—Ä–į–Ĺ–ĺ –ī–Ĺ–Ķ—Ā The Guardian –Ņ—É–Ī–Ľ–ł–ļ—É–≤–į –Ņ–ĺ—Ä–Ķ–ī–ł—Ü–į –ĺ—ā –ī–ĺ–ļ–Ľ–į–ī–ł –∑–į –≤—ä—ā—Ä–Ķ—ą–Ĺ–ł—ā–Ķ –Ņ—Ä–į–≤–ł–Ľ–į –Ĺ–į Facebook –∑–į –ľ–ĺ–ī–Ķ—Ä–ł—Ä–į–Ĺ–Ķ –Ĺ–į –≥—Ä–į—Ą–ł—á–Ĺ–ĺ —Ā—ä–ī—ä—Ä–∂–į–Ĺ–ł–Ķ. –Ę–Ķ –ī–į–≤–į—ā –Ĺ–ĺ–≤ –Ņ–ĺ–≥–Ľ–Ķ–ī –≤—ä—Ä—Ö—É —ā–ĺ–≤–į –ļ–į–ļ –ļ–ĺ–ľ–Ņ–į–Ĺ–ł—Ź—ā–į –ĺ–Ņ—Ä–Ķ–ī–Ķ–Ľ—Ź –ļ–į–ļ–≤–ĺ –Ņ–ĺ—ā—Ä–Ķ–Ī–ł—ā–Ķ–Ľ–ł—ā–Ķ –ľ–ĺ–≥–į—ā –ī–į –Ņ—É–Ī–Ľ–ł–ļ—É–≤–į—ā, –ļ–į–ļ–≤–ĺ –ľ–ĺ–∂–Ķ –ī–į –ĺ—Ā—ā–į–Ĺ–Ķ –ł –ļ–į–ļ–≤–ĺ —ā—Ä—Ź–Ī–≤–į –ī–į –Ī—ä–ī–Ķ –Ņ—Ä–Ķ–ľ–į—Ö–Ĺ–į—ā–ĺ. –°—ā–į–≤–į —Ź—Ā–Ĺ–ĺ, —á–Ķ Facebook –Ī—É–ļ–≤–į–Ľ–Ĺ–ĺ —Ā–Ķ –ī–į–≤–ł –≤ —Ā—ä–ī—ä—Ä–∂–į–Ĺ–ł–Ķ –∑–į—Ä–į–ī–ł –Ņ—Ä–į–≤–ł–Ľ–į, –ļ–ĺ–ł—ā–ĺ —Ā–į –Ĺ–į–Ļ-–ľ–Ķ–ļ–ĺ –ļ–į–∑–į–Ĺ–ĺ –Ņ—Ä–ĺ—ā–ł–≤–ĺ—Ä–Ķ—á–ł–≤–ł.

The Guardian –Ņ—É–Ī–Ľ–ł–ļ—É–≤–į —Ā–Ķ—Ä–ł—Ź –ĺ—ā Facebook —Ą–į–Ļ–Ľ–ĺ–≤–Ķ, –ļ–ĺ–ł—ā–ĺ —Ä–į–∑–ļ—Ä–ł–≤–į—ā –Ĺ—Ź–ļ–ĺ–ł –ĺ—ā –≤—ä—ā—Ä–Ķ—ą–Ĺ–ł—ā–Ķ —Ä—ä–ļ–ĺ–≤–ĺ–ī—Ā—ā–≤–į –Ĺ–į —Ā–į–Ļ—ā–į –ĺ—ā–Ĺ–ĺ—Ā–Ĺ–ĺ –ī–ĺ—Ā—ā–ĺ–≤–Ķ—Ä–Ĺ–ł –∑–į–Ņ–Ľ–į—Ö–ł –∑–į –Ĺ–į—Ā–ł–Ľ–ł–Ķ, –Ĺ–Ķ—Ā–Ķ–ļ—Ā—É–į–Ľ–Ĺ–ĺ –ľ–į–Ľ—ā—Ä–Ķ—ā–ł—Ä–į–Ĺ–Ķ –Ĺ–į –ī–Ķ—Ü–į, –∂–Ķ—Ā—ā–ĺ–ļ–ĺ—Ā—ā –ļ—ä–ľ –∂–ł–≤–ĺ—ā–Ĺ–ł –ł –ī—Ä. –ė–∑–ī–į–Ĺ–ł–Ķ—ā–ĺ –ĺ–Ī—Ź—Ā–Ĺ—Ź–≤–į, —á–Ķ —Ā–į –Ņ—Ä–Ķ–≥–Ľ–Ķ–ī–į–Ĺ–ł –Ĺ–į–ī 100 –≤—ä—ā—Ä–Ķ—ą–Ĺ–ł "—Ä—ä–ļ–ĺ–≤–ĺ–ī—Ā—ā–≤–į –∑–į –ĺ–Ī—É—á–Ķ–Ĺ–ł–Ķ, –Ķ–Ľ–Ķ–ļ—ā—Ä–ĺ–Ĺ–Ĺ–ł —ā–į–Ī–Ľ–ł—Ü–ł –ł –≥—Ä–į—Ą–ł–ļ–ł“, –ļ–ĺ–ł—ā–ĺ –Ĺ–į—Ā–ĺ—á–≤–į—ā –ľ–ĺ–ī–Ķ—Ä–į—ā–ĺ—Ä–ł—ā–Ķ –Ĺ–į —Ā–į–Ļ—ā–į, –ļ–ĺ–≥–į—ā–ĺ –ł–ľ–į –ī–ĺ–ļ–Ľ–į–ī–≤–į–Ĺ–ĺ —Ā—ä–ī—ä—Ä–∂–į–Ĺ–ł–Ķ.

–Ē–ĺ–ļ—É–ľ–Ķ–Ĺ—ā–ł—ā–Ķ —Ä–į–∑–ļ—Ä–ł–≤–į—ā, —á–Ķ Facebook –ł–∑–Ņ–ĺ–Ľ–∑–≤–į –Ĺ—Ź–ļ–ĺ–ł –į–≤—ā–ĺ–ľ–į—ā–ł–∑–ł—Ä–į–Ĺ–ł —Ā–ł—Ā—ā–Ķ–ľ–ł –∑–į –į–ļ—ā–ł–≤–Ĺ–ĺ –Ņ—Ä–Ķ–ľ–į—Ö–≤–į–Ĺ–Ķ –Ĺ–į —Ā—ä–ī—ä—Ä–∂–į–Ĺ–ł–Ķ, –ļ–į—ā–ĺ –Ĺ–į–Ņ—Ä–ł–ľ–Ķ—Ä —Ā–Ķ–ļ—Ā—É–į–Ľ–Ĺ–į –∑–Ľ–ĺ—É–Ņ–ĺ—ā—Ä–Ķ–Ī–į —Ā –ī–Ķ—Ü–į –ł–Ľ–ł —ā–Ķ—Ä–ĺ—Ä–ł–∑—ä–ľ, –į –ĺ—Ā—ā–į–Ĺ–į–Ľ–ł—ā–Ķ –Ĺ–Ķ—Č–į –Ņ–į–ī–į—ā –≤—ä—Ä—Ö—É –Ķ–ļ–ł–Ņ–ł—ā–Ķ –ĺ—ā –ľ–ĺ–ī–Ķ—Ä–į—ā–ĺ—Ä–ł.

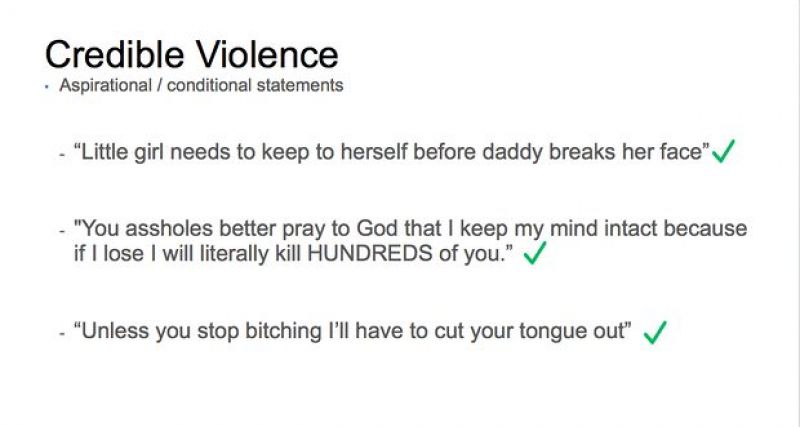

–í –Ĺ—Ź–ļ–ĺ–ł –ĺ—ā –ī–ĺ–ļ—É–ľ–Ķ–Ĺ—ā–ł—ā–Ķ –ł–ľ–į —Ä—ä–ļ–ĺ–≤–ĺ–ī—Ā—ā–≤–į –∑–į —ā–ĺ–≤–į –ļ–į–ļ —ā—Ä—Ź–Ī–≤–į –ī–į —Ā–Ķ –Ņ–ĺ—Ā—ā—ä–Ņ–≤–į, –ļ–ĺ–≥–į—ā–ĺ —Ö–ĺ—Ä–į—ā–į –ł–∑—Ä–į–∑—Ź–≤–į—ā –Ĺ–Ķ—Ā—ä–≥–Ľ–į—Ā–ł–Ķ —Ā –ĺ–Ņ–į—Ā–Ĺ–ĺ—Ā—ā—ā–į –∑–į –∂–ł–≤–ĺ—ā–į –ł–Ľ–ł –Ņ—Ä–ł–∑–ĺ–≤–į–≤–į—ā –∑–į –Ĺ–į—Ā–ł–Ľ–ł–Ķ –Ņ–ĺ –ĺ–Ī—Č–ĺ —ą–Ķ–≥–ĺ–≤–ł—ā–ł –ł –Ĺ–Ķ—Ā–Ķ—Ä–ł–ĺ–∑–Ĺ–ł –Ĺ–į—á–ł–Ĺ–ł. –°—ä—Č–ĺ —ā–į–ļ–į —Ā–Ķ –Ņ—Ä–Ķ–ī–ĺ—Ā—ā–į–≤—Ź—ā –Ņ—Ä–ł–ľ–Ķ—Ä–ł, –Ņ—Ä–ł –ļ–ĺ–ł—ā–ĺ –Ĺ—Ź–ļ–ĺ–ł —ā–≤—ä—Ä–ī–Ķ–Ĺ–ł—Ź —Ā–į –Ņ—Ä–ł–Ķ–ľ–Ľ–ł–≤–ł –ī–į –ĺ—Ā—ā–į–Ĺ–į—ā –Ĺ–į —Ā–į–Ļ—ā–į (–ļ–į—ā–ĺ „–ź–∑ –ĺ—ā–ł–≤–į–ľ –ī–į —É–Ī–ł—Ź –Ē–∂–ĺ–Ĺ!"), –Ĺ–ĺ —ā–ĺ–≤–į, –ļ–ĺ–Ķ—ā–ĺ —ā—Ä—Ź–Ī–≤–į –ī–į –Ī—ä–ī–Ķ –Ņ—Ä–Ķ–ľ–į—Ö–Ĺ–į—ā–ĺ, –Ķ „–ź–∑ —Č–Ķ —ā–Ķ —É–Ī–ł—Ź –Ē–∂–ĺ–Ĺ, –ł–ľ–į–ľ –Ĺ–ĺ–∂, –∑–į –ī–į –≥–ĺ –Ĺ–į–Ņ—Ä–į–≤—Ź!“.

–Ě–į—Ā–ĺ–ļ–ł—ā–Ķ –∑–į –ľ–ĺ–ī–Ķ—Ä–į—ā–ĺ—Ä–ł—ā–Ķ –ĺ–Ņ—Ä–Ķ–ī–Ķ–Ľ—Ź—ā —Ä–į–∑–Ľ–ł–ļ–į—ā–į –ľ–Ķ–∂–ī—É –Ĺ—Ź–ļ–ĺ–Ļ, –ļ–ĺ–Ļ—ā–ĺ –Ķ „–ł–∑–Ņ—É—Ā–Ĺ–į–Ľ –Ņ–į—Ä–į“ –ł —Ā–Ķ—Ä–ł–ĺ–∑–Ĺ–į –∑–į–Ņ–Ľ–į—Ö–į, –ļ–į—ā–ĺ –ļ–ĺ–Ĺ–ļ—Ä–Ķ—ā–Ĺ–ł –∑–į–Ņ–Ľ–į—Ö–ł, –≤—Ä–Ķ–ľ–Ķ –ł –ľ–Ķ—ā–ĺ–ī–ł –∑–į –ł–∑–≤—ä—Ä—ą–≤–į–Ĺ–Ķ.

Facebook —Ā—ä—Č–ĺ —ā–į–ļ–į –ĺ—á–Ķ—Ä—ā–į–≤–į –ļ–ĺ–Ĺ–ļ—Ä–Ķ—ā–Ĺ–ł –≥—Ä—É–Ņ–ł –ĺ—ā —É—Ź–∑–≤–ł–ľ–ł –Ľ–ł—Ü–į (–ļ–į—ā–ĺ –ī—ä—Ä–∂–į–≤–Ĺ–ł —Ä—ä–ļ–ĺ–≤–ĺ–ī–ł—ā–Ķ–Ľ–ł –ł–Ľ–ł —Ā–Ņ–Ķ—Ü–ł—Ą–ł—á–Ĺ–ł –Ņ–ĺ–Ľ–ł—Ü–Ķ–Ļ—Ā–ļ–ł —Ā–Ľ—É–∂–ł—ā–Ķ–Ľ–ł) –ł –≥—Ä—É–Ņ–ł (–Ī–Ķ–∑–ī–ĺ–ľ–Ĺ–ł—Ü–ł –Ĺ–į–Ņ—Ä–ł–ľ–Ķ—Ä), –ļ–ĺ–ł—ā–ĺ –į–≤—ā–ĺ–ľ–į—ā–ł—á–Ĺ–ĺ —Ā–Ķ –ł–∑—ā—Ä–ł–≤–į—ā.

–Ě–ĺ –ĺ—ā —ā–Ķ–∑–ł –ī–ĺ–ļ—É–ľ–Ķ–Ĺ—ā–ł —Ā—ā–į–≤–į —Ź—Ā–Ĺ–ĺ, —á–Ķ —Ā–į –Ĺ–į–Ľ–ł—Ü–Ķ –∑–Ĺ–į—á–ł—ā–Ķ–Ľ–Ĺ–ł „—Ā–ł–≤–ł –∑–ĺ–Ĺ–ł“. –í –Ĺ–į—Ā–ĺ–ļ–ł—ā–Ķ –Ĺ–į —Ā–į–Ļ—ā–į –ł–∑—Ä–ł—á–Ĺ–ĺ —Ā–Ķ –Ņ–ĺ—Ā–ĺ—á–≤–į, —á–Ķ —Ā–Ķ —Ä–į–∑—Ä–Ķ—ą–į–≤–į—ā "—Ā–Ĺ–ł–ľ–ļ–ł –ł –≤–ł–ī–Ķ–ĺ–ļ–Ľ–ł–Ņ–ĺ–≤–Ķ, –ļ–ĺ–ł—ā–ĺ –ī–ĺ–ļ—É–ľ–Ķ–Ĺ—ā–ł—Ä–į—ā –∑–Ľ–ĺ—É–Ņ–ĺ—ā—Ä–Ķ–Ī–į —Ā –∂–ł–≤–ĺ—ā–Ĺ–ł", –∑–į –ī–į —Ā–Ķ –Ņ–ĺ–≤–ł—ą–ł –ł–Ĺ—Ą–ĺ—Ä–ľ–ł—Ä–į–Ĺ–ĺ—Ā—ā—ā–į. –Ē–ĺ–ļ–į—ā–ĺ Facebook –Ĺ–Ķ —Ä–į–∑—Ä–Ķ—ą–į–≤–į –ī–į —Ā–Ķ –ļ–į—á–≤–į—ā –ł–∑–ĺ–Ī—Ä–į–∂–Ķ–Ĺ–ł—Ź –ł –≤–ł–ī–Ķ–ĺ–ļ–Ľ–ł–Ņ–ĺ–≤–Ķ —Ā –Ĺ–į—Ā–ł–Ľ–ł–Ķ –Ĺ–į–ī –ī–Ķ—Ü–į, —ā–ĺ –Ņ–ĺ–ī–ĺ–Ī–Ĺ–ĺ —Ā—ä–ī—ä—Ä–∂–į–Ĺ–ł–Ķ —Ā –∂–ł–≤–ĺ—ā–Ĺ–ł —Ā–Ķ –ľ–į—Ä–ļ–ł—Ä–į –Ķ–ī–ł–Ĺ—Ā—ā–≤–Ķ–Ĺ–ĺ –ļ–į—ā–ĺ „—ā—Ä–Ķ–≤–ĺ–∂–Ĺ–ĺ“. –í —ā–ĺ–≤–į —á–ł—Ā–Ľ–ĺ –≤–Ľ–ł–∑–į—ā –ī–ĺ—Ä–ł —Ā–Ĺ–ł–ľ–ļ–ł, –Ĺ–į –ļ–ĺ–ł—ā–ĺ —Ź—Ā–Ĺ–ĺ —Ā–Ķ –Ņ–ĺ–ļ–į–∑–≤–į –ļ–į–ļ —Ö–ĺ—Ä–į —Ä–ł—ā–į—ā –ł–Ľ–ł –Ī–ł—Ź—ā –∂–ł–≤–ĺ—ā–Ĺ–ł - –ĺ—ā–Ĺ–ĺ–≤–ĺ —Ā —Ü–Ķ–Ľ –ĺ–Ī—Ä—ä—Č–į–Ĺ–į –Ĺ–Ķ –≤–Ĺ–ł–ľ–į–Ĺ–ł–Ķ –ļ—ä–ľ –Ņ—Ä–ĺ–Ī–Ľ–Ķ–ľ–į —Ā –Ĺ–į—Ā–ł–Ľ–ł–Ķ—ā–ĺ.

–Ě–ĺ –ĺ—ā —ā–Ķ–∑–ł –ī–ĺ–ļ—É–ľ–Ķ–Ĺ—ā–ł —Ā—ā–į–≤–į —Ź—Ā–Ĺ–ĺ, —á–Ķ —Ā–į –Ĺ–į–Ľ–ł—Ü–Ķ –∑–Ĺ–į—á–ł—ā–Ķ–Ľ–Ĺ–ł „—Ā–ł–≤–ł –∑–ĺ–Ĺ–ł“. –í –Ĺ–į—Ā–ĺ–ļ–ł—ā–Ķ –Ĺ–į —Ā–į–Ļ—ā–į –ł–∑—Ä–ł—á–Ĺ–ĺ —Ā–Ķ –Ņ–ĺ—Ā–ĺ—á–≤–į, —á–Ķ —Ā–Ķ —Ä–į–∑—Ä–Ķ—ą–į–≤–į—ā "—Ā–Ĺ–ł–ľ–ļ–ł –ł –≤–ł–ī–Ķ–ĺ–ļ–Ľ–ł–Ņ–ĺ–≤–Ķ, –ļ–ĺ–ł—ā–ĺ –ī–ĺ–ļ—É–ľ–Ķ–Ĺ—ā–ł—Ä–į—ā –∑–Ľ–ĺ—É–Ņ–ĺ—ā—Ä–Ķ–Ī–į —Ā –∂–ł–≤–ĺ—ā–Ĺ–ł", –∑–į –ī–į —Ā–Ķ –Ņ–ĺ–≤–ł—ą–ł –ł–Ĺ—Ą–ĺ—Ä–ľ–ł—Ä–į–Ĺ–ĺ—Ā—ā—ā–į. –Ē–ĺ–ļ–į—ā–ĺ Facebook –Ĺ–Ķ —Ä–į–∑—Ä–Ķ—ą–į–≤–į –ī–į —Ā–Ķ –ļ–į—á–≤–į—ā –ł–∑–ĺ–Ī—Ä–į–∂–Ķ–Ĺ–ł—Ź –ł –≤–ł–ī–Ķ–ĺ–ļ–Ľ–ł–Ņ–ĺ–≤–Ķ —Ā –Ĺ–į—Ā–ł–Ľ–ł–Ķ –Ĺ–į–ī –ī–Ķ—Ü–į, —ā–ĺ –Ņ–ĺ–ī–ĺ–Ī–Ĺ–ĺ —Ā—ä–ī—ä—Ä–∂–į–Ĺ–ł–Ķ —Ā –∂–ł–≤–ĺ—ā–Ĺ–ł —Ā–Ķ –ľ–į—Ä–ļ–ł—Ä–į –Ķ–ī–ł–Ĺ—Ā—ā–≤–Ķ–Ĺ–ĺ –ļ–į—ā–ĺ „—ā—Ä–Ķ–≤–ĺ–∂–Ĺ–ĺ“. –í —ā–ĺ–≤–į —á–ł—Ā–Ľ–ĺ –≤–Ľ–ł–∑–į—ā –ī–ĺ—Ä–ł —Ā–Ĺ–ł–ľ–ļ–ł, –Ĺ–į –ļ–ĺ–ł—ā–ĺ —Ź—Ā–Ĺ–ĺ —Ā–Ķ –Ņ–ĺ–ļ–į–∑–≤–į –ļ–į–ļ —Ö–ĺ—Ä–į —Ä–ł—ā–į—ā –ł–Ľ–ł –Ī–ł—Ź—ā –∂–ł–≤–ĺ—ā–Ĺ–ł - –ĺ—ā–Ĺ–ĺ–≤–ĺ —Ā —Ü–Ķ–Ľ –ĺ–Ī—Ä—ä—Č–į–Ĺ–į –Ĺ–Ķ –≤–Ĺ–ł–ľ–į–Ĺ–ł–Ķ –ļ—ä–ľ –Ņ—Ä–ĺ–Ī–Ľ–Ķ–ľ–į —Ā –Ĺ–į—Ā–ł–Ľ–ł–Ķ—ā–ĺ.

–ü–ĺ—ā—Ä–Ķ–Ī–ł—ā–Ķ–Ľ–ł—ā–Ķ, –ļ–ĺ–ł—ā–ĺ —Ā–į —Ā–ļ–Ľ–ĺ–Ĺ–Ĺ–ł –ī–į —Ā–Ķ —Ā–į–ľ–ĺ–Ĺ–į—Ä–į–Ĺ—Ź—ā, —Ā—ä—Č–ĺ –Ĺ–Ķ —Ā–Ķ —Ü–Ķ–Ĺ–∑—É—Ä–ł—Ä–į—ā. –ě—ā –≤—ä—ā—Ä–Ķ—ą–Ĺ–ł—ā–Ķ –Ņ—Ä–į–≤–ł–Ľ–į –Ĺ–į—É—á–į–≤–į–ľ–Ķ –ĺ—Č–Ķ, —á–Ķ "–≤–ł–ī–Ķ–į —Ā –Ĺ–į—Ā–ł–Ľ—Ā—ā–≤–Ķ–Ĺ–į —Ā–ľ—ä—Ä—ā —Ā–į –ĺ–Ī–Ķ–∑–Ņ–ĺ–ļ–ĺ–ł—ā–Ķ–Ľ–Ĺ–ł, –Ĺ–ĺ –ľ–ĺ–≥–į –ī–į —Ā–Ķ –ł–∑–Ņ–ĺ–Ľ–∑–≤–į—ā, –∑–į –ī–į —Ā–Ķ —É–≤–Ķ–Ľ–ł—á–ł –ł–Ĺ—Ą–ĺ—Ä–ľ–ł—Ä–į–Ĺ–ĺ—Ā—ā—ā–į –ł –ĺ—Ā—ä–∑–Ĺ–į–≤–į–Ĺ–Ķ—ā–ĺ –Ĺ–į –Ņ—Ä–ĺ–Ī–Ľ–Ķ–ľ–ł—ā–Ķ. –ź–ļ–ĺ –≥–ĺ–≤–ĺ—Ä–ł–ľ –∑–į –≤–ł–ī–Ķ–į—ā–į, —Ā–ľ—Ź—ā–į–ľ–Ķ, —á–Ķ –ľ–į–Ľ–ĺ–Ľ–Ķ—ā–Ĺ–ł—ā–Ķ —ā—Ä—Ź–Ī–≤–į –ī–į –Ī—ä–ī–į—ā –∑–į—Č–ł—ā–į–≤–į–Ĺ–ł, –į –≤—ä–∑—Ä–į—Ā—ā–Ĺ–ł—ā–Ķ - –ī–į –ł–ľ–į—ā –ł–∑–Ī–ĺ—Ä". –ü–ĺ–ī–ĺ–Ī–Ĺ–ĺ —Ā—ä–ī—ä—Ä–∂–į–Ĺ–ł–Ķ —ā—Ä—Ź–Ī–≤–į –ī–į –Ī—ä–ī–Ķ —Ā–ļ—Ä–ł–≤–į–Ĺ–ĺ –ĺ—ā –ľ–į–Ľ–ĺ–Ľ–Ķ—ā–Ĺ–ł—ā–Ķ, –Ĺ–ĺ –ī–į –Ĺ–Ķ –Ī—ä–ī–Ķ –ł–∑—ā—Ä–ł–≤–į–Ĺ–ĺ, –∑–į –ī–į —Ā–Ķ –ł–∑–Ņ–ĺ–Ľ–∑–≤–į –ł–ľ–Ķ–Ĺ–Ĺ–ĺ –∑–į –ĺ–Ī—Ä—ä—Č–į–Ĺ–Ķ –Ĺ–į –≤–Ĺ–ł–ľ–į–Ĺ–ł–Ķ –Ĺ–į –≤–į–∂–Ĺ–ł—ā–Ķ –≤—ä–Ņ—Ä–ĺ—Ā–ł –∑–į –Ĺ–į—Ā–ł–Ľ–ł–Ķ—ā–ĺ, —Ā–į–ľ–ĺ–Ĺ–į—Ä–į–Ĺ—Ź–≤–į–Ĺ–Ķ—ā–ĺ –ł —ā.–Ĺ.

„–ú–ĺ–ī–Ķ—Ä–į—ā–ĺ—Ä–ł –Ņ—Ä–Ķ–≥–Ľ–Ķ–∂–ī–į—ā –ľ–ł–Ľ–ł–ĺ–Ĺ–ł —Ā—ä–ĺ–Ī—Č–Ķ–Ĺ–ł—Ź –∑–į —Ā—ä–ľ–Ĺ–ł—ā–Ķ–Ľ–Ĺ–ĺ —Ā—ä–ī—ä—Ä–∂–į–Ĺ–ł–Ķ –ł —ā–Ķ „—á–Ķ—Ā—ā–ĺ —Ā–Ķ —á—É–≤—Ā—ā–≤–į—ā –Ņ—Ä–Ķ—ā–ĺ–≤–į—Ä–Ķ–Ĺ–ł –ĺ—ā –Ī—Ä–ĺ—Ź –Ĺ–į –Ņ—É–Ī–Ľ–ł–ļ–į—Ü–ł–ł—ā–Ķ, –ļ–ĺ–ł—ā–ĺ —ā—Ä—Ź–Ī–≤–į –ī–į –Ņ—Ä–Ķ–≥–Ľ–Ķ–ī–į—ā, –ļ–ĺ–Ķ—ā–ĺ –≥–ł –ļ–į—Ä–į –ī–į –Ņ—Ä–į–≤—Ź—ā –≥—Ä–Ķ—ą–ļ–ł, –ĺ—Ā–ĺ–Ī–Ķ–Ĺ–ĺ –≤ —Ā–Ľ–ĺ–∂–Ĺ–į—ā–į –ĺ–Ī–Ľ–į—Ā—ā –Ĺ–į –ī–ĺ–Ņ—É—Ā—ā–ł–ľ–ĺ—ā–ĺ —Ā–Ķ–ļ—Ā—É–į–Ľ–Ĺ–ĺ —Ā—ä–ī—ä—Ä–∂–į–Ĺ–ł–Ķ“, –∑–į—Ź–≤–ł —Ä—ä–ļ–ĺ–≤–ĺ–ī–ł—ā–Ķ–Ľ—Ź—ā –Ĺ–į –≥–Ľ–ĺ–Ī–į–Ľ–Ĺ–į—ā–į –Ņ–ĺ–Ľ–ł—ā–ł–ļ–į –Ĺ–į Facebook –ú–ĺ–Ĺ–ł–ļ–į –Ď–ł–ļ–Ķ—Ä—ā –Ņ—Ä–Ķ–ī The Guardian.

–†–į–∑–Ĺ–ĺ–ĺ–Ī—Ä–į–∑–Ĺ–į—ā–į –į—É–ī–ł—ā–ĺ—Ä–ł—Ź –Ĺ–į –ļ–ĺ–ľ–Ņ–į–Ĺ–ł—Ź—ā–į –ĺ–∑–Ĺ–į—á–į–≤–į –ł —á–Ķ –ł–ľ–į –≥–ĺ–Ľ—Ź–ľ–ĺ —Ä–į–∑–Ĺ–ĺ–ĺ–Ī—Ä–į–∑–ł–Ķ –ĺ—ā —ā–ĺ–≤–į, –ļ–ĺ–Ķ—ā–ĺ —Ā–Ķ —Ā–ľ—Ź—ā–į –∑–į –Ņ—Ä–ł–Ķ–ľ–Ľ–ł–≤–ĺ –Ņ–ĺ–≤–Ķ–ī–Ķ–Ĺ–ł–Ķ, –ļ–į–ļ—ā–ĺ –ł —á–Ķ –Ĺ—Ź–ļ–ĺ–ł –ļ–ĺ–ľ–Ķ–Ĺ—ā–į—Ä–ł –ľ–ĺ–≥–į—ā –ī–į –Ĺ–į—Ä—É—ą–į–≤–į—ā –Ņ—Ä–į–≤–ł–Ľ–į—ā–į –Ĺ–į Facebook –≤ –Ĺ—Ź–ļ–ĺ–ł —Ā–ł—ā—É–į—Ü–ł–ł, –Ĺ–ĺ –Ĺ–Ķ –ł –ī—Ä—É–≥–ł.

–í –ł–∑—Ź–≤–Ľ–Ķ–Ĺ–ł–Ķ –Ņ—Ä–Ķ–ī The Verge –Ď–ł–ļ–Ķ—Ä—ā –ĺ—ā–Ī–Ķ–Ľ—Ź–∑–≤–į, —á–Ķ –Ī–Ķ–∑–ĺ–Ņ–į—Ā–Ĺ–ĺ—Ā—ā—ā–į –Ĺ–į –Ņ–ĺ—ā—Ä–Ķ–Ī–ł—ā–Ķ–Ľ–ł—ā–Ķ –Ķ –ĺ—ā –ł–∑–ļ–Ľ—é—á–ł—ā–Ķ–Ľ–Ĺ–ĺ –∑–Ĺ–į—á–Ķ–Ĺ–ł–Ķ –∑–į Facebook:

"–Ē–į —Ä–į–Ī–ĺ—ā–ł–ľ –∑–į —ā–ĺ–≤–į –Ņ–ĺ—ā—Ä–Ķ–Ī–ł—ā–Ķ–Ľ–ł—ā–Ķ –Ĺ–į Facebook –ī–į —Ā–į –≤ –Ī–Ķ–∑–ĺ–Ņ–į—Ā–Ĺ–ĺ—Ā—ā –Ķ –Ĺ–į–Ļ-–≤–į–∂–Ĺ–ĺ—ā–ĺ –Ĺ–Ķ—Č–ĺ –∑–į –Ĺ–į—Ā. –ú–į—Ä–ļ –ó—É–ļ—ä—Ä–Ī—ä—Ä–≥ –Ĺ–į—Ā–ļ–ĺ—Ä–ĺ –ĺ–Ī—Ź–≤–ł, —á–Ķ –Ņ—Ä–Ķ–∑ —Ā–Ľ–Ķ–ī–≤–į—Č–į—ā–į –≥–ĺ–ī–ł–Ĺ–į —Č–Ķ –Ī—ä–ī–į—ā –Ĺ–į–Ķ—ā–ł –ĺ—Č–Ķ 3000 –ī—É—ą–ł –ļ—ä–ľ –Ĺ–į—ą–ł—Ź –Ķ–ļ–ł–Ņ –Ņ–ĺ —Ü–Ķ–Ľ–ł—Ź —Ā–≤—Ź—ā. –Ę–ĺ–≤–į —Č–Ķ –Ņ–ĺ–∑–≤–ĺ–Ľ–ł –ī–į —Ā–Ķ –Ņ—Ä–Ķ–≥–Ľ–Ķ–∂–ī–į—ā –Ņ–ĺ-–Ī—ä—Ä–∑–ĺ –ł —ā–ĺ—á–Ĺ–ĺ –ľ–ł–Ľ–ł–ĺ–Ĺ–ł—ā–Ķ —Ā–ł–≥–Ĺ–į–Ľ–ł, –ļ–ĺ–ł—ā–ĺ –Ņ–ĺ–Ľ—É—á–į–≤–į–ľ–Ķ –≤—Ā—Ź–ļ–į —Ā–Ķ–ī–ľ–ł—Ü–į. –©–Ķ –Ņ–ĺ–ī–ĺ–Ī—Ä—Ź–≤–į–ľ–Ķ –Ņ—Ä–ĺ—Ü–Ķ—Ā–į, –∑–į –ī–į –≥–ĺ –Ĺ–į–Ņ—Ä–į–≤–ł–ľ –Ņ–ĺ-–Ī—ä—Ä–∑. –í –ī–ĺ–Ņ—ä–Ľ–Ĺ–Ķ–Ĺ–ł–Ķ –ļ—ä–ľ –ł–Ĺ–≤–Ķ—Ā—ā–ł—Ä–į–Ĺ–Ķ –≤ –Ņ–ĺ–≤–Ķ—á–Ķ —Ö–ĺ—Ä–į, —Ā—ä—Č–ĺ —ā–į–ļ–į –ł–∑–≥—Ä–į–∂–ī–į–ľ–Ķ –Ņ–ĺ-–ī–ĺ–Ī—Ä–ł –ł–Ĺ—Ā—ā—Ä—É–ľ–Ķ–Ĺ—ā–ł, –∑–į –ī–į –ī—ä—Ä–∂–ł–ľ –ĺ–Ī—Č–Ĺ–ĺ—Ā—ā—ā–į –Ĺ–ł –≤ –Ī–Ķ–∑–ĺ–Ņ–į—Ā–Ĺ–ĺ—Ā—ā. –©–Ķ —É–Ľ–Ķ—Ā–Ĺ–ł–ľ –ĺ–Ņ—Ä–Ķ–ī–Ķ–Ľ—Ź–Ĺ–Ķ—ā–ĺ –Ĺ–į —ā–ĺ–≤–į –ļ–ĺ–ł –Ņ—É–Ī–Ľ–ł–ļ–į—Ü–ł–ł –Ĺ–į—Ä—É—ą–į–≤–į—ā –Ĺ–į—ą–ł—ā–Ķ —Ā—ā–į–Ĺ–ī–į—Ä—ā–ł, –∑–į –ī–į –Ņ—Ä–ł–Ľ–į–≥–į–ľ–Ķ –∑–į–ļ–ĺ–Ĺ–į, –į–ļ–ĺ –Ĺ—Ź–ļ–ĺ–Ļ –ł–ľ–į –Ĺ—É–∂–ī–į –ĺ—ā –Ņ–ĺ–ľ–ĺ—Č.“

–ě—ā The Guardian –ī–ĺ–Ī–į–≤—Ź—ā –ĺ—Č–Ķ, —á–Ķ —Ā–Ņ–ĺ—Ä–Ķ–ī –Ņ—Ä–į–≤–ł–Ľ–į—ā–į –Ĺ–į Facebook —Ā—ā—Ä–ł–Ļ–ľ –Ĺ–į –∂–ł–≤–ĺ, –≤ –ļ–ĺ–Ļ—ā–ĺ —Ā–Ķ –≤–ł–∂–ī–į—ā –ĺ–Ņ–ł—ā–ł –∑–į —Ā–į–ľ–ĺ–Ĺ–į—Ä–į–Ĺ—Ź–≤–į–Ĺ–Ķ –Ĺ—Ź–ľ–į –ī–į –Ī—ä–ī–į—ā —Ā–Ņ–ł—Ä–į–Ĺ–ł, –∑–į—Č–ĺ—ā–ĺ "–Ĺ–Ķ –ł—Ā–ļ–į –ī–į —Ü–Ķ–Ĺ–∑—É—Ä–ł—Ä–į –ł–Ľ–ł –Ĺ–į–ļ–į–∑–≤–į —Ö–ĺ—Ä–į –≤ —ā–Ķ–∂–ļ–į —Ā–ł—ā—É–į—Ü–ł—Ź, –ļ–ĺ–ł—ā–ĺ –Ņ—Ä–ł–Ī—Ź–≥–≤–į—ā –ļ—ä–ľ —Ā–į–ľ–ĺ—É–Ī–ł–Ļ—Ā—ā–≤–ĺ". –í—Ā–Ķ –Ņ–į–ļ –≤–ł–ī–Ķ–ĺ—ā–ĺ —Č–Ķ –Ī—ä–ī–Ķ –Ņ—Ä–Ķ–ľ–į—Ö–Ĺ–į—ā–ĺ –≤ –ľ–ĺ–ľ–Ķ–Ĺ—ā–į, –≤ –ļ–ĺ–Ļ—ā–ĺ —Ā—ā–į–Ĺ–Ķ —Ź—Ā–Ĺ–ĺ, —á–Ķ –≤–Ķ—á–Ķ –Ĺ–Ķ –Ņ—Ä–Ķ–ī–ĺ—Ā—ā–į–≤—Ź –≤—ä–∑–ľ–ĺ–∂–Ĺ–ĺ—Ā—ā –ī–į —Ā–Ķ –Ņ–ĺ–ľ–ĺ–≥–Ĺ–Ķ –Ĺ–į —á–ĺ–≤–Ķ–ļ–į. –Ę–į–∑–ł –Ņ–ĺ–Ľ–ł—ā–ł–ļ–į –Ķ –ł–∑–≥–ĺ—ā–≤–Ķ–Ĺ–į –Ĺ–į –Ī–į–∑–į —Ä–į–∑–≥–ĺ–≤–ĺ—Ä–ł —Ā –Ķ–ļ—Ā–Ņ–Ķ—Ä—ā–ł, –Ņ–ł—ą–Ķ –ĺ—Č–Ķ –≤—ä–≤ —Ą–į–Ļ–Ľ–ĺ–≤–Ķ—ā–Ķ, –ī–ĺ –ļ–ĺ–ł—ā–ĺ —Ā–į –ī–ĺ—Ā—ā–ł–≥–Ĺ–į–Ľ–ł –ĺ—ā –ł–∑–ī–į–Ĺ–ł–Ķ—ā–ĺ.

–ė—Ā—ā–ł–Ĺ–į—ā–į –Ķ, —á–Ķ Facebook —Ā–Ķ —Ä–į–∑–≤–ł–≤–į —Ā —ą–Ķ–ľ–Ķ—ā–Ĺ–ł —ā–Ķ–ľ–Ņ–ĺ–≤–Ķ –ł –≤—Ā—ä—Č–Ĺ–ĺ—Ā—ā –Ķ —Ā–≤–ĺ–Ķ–ĺ–Ī—Ä–į–∑–Ķ–Ĺ —Ą–Ķ–Ĺ–ĺ–ľ–Ķ–Ĺ, –ļ–ĺ–Ļ—ā–ĺ –ī–ĺ —ā–ĺ–∑–ł –ľ–ĺ–ľ–Ķ–Ĺ—ā –Ĺ–Ķ –Ķ —Ā—ä—Č–Ķ—Ā—ā—É–≤–į–Ľ. –ě—Ą–ĺ—Ä–ľ—Ź–Ĺ–Ķ—ā–ĺ –ľ—É –≤ –Ī–Ķ–∑–ĺ–Ņ–į—Ā–Ĺ–ĺ –ł –ł–∑–ĺ–Ľ–ł—Ä–į–Ĺ–ĺ –ĺ—ā –≥—Ä–į—Ą–ł—á–Ĺ–ĺ —Ā—ä–ī—ä—Ä–∂–į–Ĺ–ł–Ķ –ľ—Ź—Ā—ā–ĺ –Ķ –Ĺ–Ķ—Č–ĺ –ł–∑–ļ–Ľ—é—á–ł—ā–Ķ–Ľ–Ĺ–ĺ —ā—Ä—É–ī–Ĺ–ĺ, –į –≤–∑–Ķ–ľ–į–Ĺ–Ķ—ā–ĺ –Ĺ–į –ī–Ķ–Ľ–ł–ļ–į—ā–Ĺ–ł —Ä–Ķ—ą–Ķ–Ĺ–ł—Ź - –ĺ—Č–Ķ –Ņ–ĺ-—Ā–Ľ–ĺ–∂–Ĺ–ĺ. –ź–ļ–ĺ —á–ĺ–≤–Ķ–ļ –ł–ľ–į —Ā–Ķ—Ä–ł–ĺ–∑–Ĺ–ł –Ņ—Ä–ĺ–Ī–Ľ–Ķ–ľ–ł –ł –Ķ –Ņ–ĺ–≥—ä–Ľ–Ĺ–į—ā –ĺ—ā –ī—ä–Ľ–Ī–ĺ–ļ–į –ī–Ķ–Ņ—Ä–Ķ—Ā–ł—Ź, –ī–ĺ–Ņ—ä–Ľ–Ĺ–ł—ā–Ķ–Ľ–Ĺ–ĺ—ā–ĺ –ľ—É –ł–∑–ĺ–Ľ–ł—Ä–į–Ĺ–Ķ –ľ–ĺ–∂–Ķ –ī–į –ľ—É –Ĺ–į–≤—Ä–Ķ–ī–ł –ĺ—Č–Ķ –Ņ–ĺ–≤–Ķ—á–Ķ. –Ę–ĺ–≤–į –Ķ –ł –Ņ—Ä–ł—á–ł–Ĺ–į—ā–į –ĺ—ā –°–ĺ—Ü–ł–į–Ľ–Ĺ–į—ā–į –ľ—Ä–Ķ–∂–į –ī–į —Ä–į–∑—Ä–į–Ī–ĺ—ā–≤–į—ā —Ā–ł—Ā—ā–Ķ–ľ–ł –∑–į –Ņ–ĺ–ľ–ĺ—Č –Ĺ–į –Ņ–ĺ—ā—Ä–Ķ–Ī–ł—ā–Ķ–Ľ–ł—ā–Ķ. –Ě–ĺ –ľ–ĺ–∂–Ķ–ľ –Ľ–ł –ī–į —Ā–Ķ —Ā—ä–≥–Ľ–į—Ā–ł–ľ —Ā –Ņ—Ä–į–≤–ł–Ľ–į—ā–į –∑–į –Ĺ–į—Ā–ł–Ľ–ł–Ķ? –Ě–į–ł—Ā—ā–ł–Ĺ–į –Ķ –≤–į–∂–Ĺ–ĺ —ā–Ķ–∑–ł –Ņ—Ä–ĺ–Ī–Ľ–Ķ–ľ–ł –ī–į –Ĺ–Ķ –Ī—ä–ī–į—ā –Ņ—Ä–Ķ–Ĺ–Ķ–Ī—Ä–Ķ–≥–≤–į–Ĺ–ł –ł –Ņ–ĺ—ā—É–Ľ–≤–į–Ĺ–ł, –Ĺ–ĺ –ļ—ä–ī–Ķ –Ķ —ā—ä–Ĺ–ļ–į—ā–į –≥—Ä–į–Ĺ–ł—Ü–į, –ļ–ĺ—Ź—ā–ĺ –Ĺ–Ķ —ā—Ä—Ź–Ī–≤–į –ī–į –Ī—ä–ī–Ķ –Ņ—Ä–Ķ–ľ–ł–Ĺ–į–≤–į–Ĺ–į?