–í—Å–µ–ª–µ–Ω–∞—Ç–∞ – –æ—Ç–∫—ä–¥–µ—Ç–æ –∏ –¥–∞ —è –ø–æ–≥–ª–µ–¥–Ω–µ—à, –µ –µ–¥–Ω–æ –¥–æ—Å—Ç–∞ –≥–æ–ª—è–º–æ –º—è—Å—Ç–æ. –í—Å—ä—â–Ω–æ—Å—Ç –≤—Å–∏—á–∫–∏ –Ω–∏–µ, –≤—Ç—Ä–µ–Ω—á–µ–Ω–∏ –≤ –µ–∂–µ–¥–Ω–µ–≤–Ω–∏—Ç–µ —Å–∏, —á–∏—Å—Ç–æ —á–æ–≤–µ—à–∫–∏, –¥—Ä–µ–±–Ω–∏ –ø—Ä–æ–±–ª–µ–º–∏, —á–µ—Å—Ç–æ –∑–∞–±—Ä–∞–≤—è–º–µ –∫–æ–ª–∫–æ —Å–º–µ—Ö–æ—Ç–≤–æ—Ä–Ω–æ –º–∞–ª–∫–∞ —á–∞—Å—Ç–∏—Ü–∞ —Å–º–µ –Ω–∏–µ –∏ –Ω–∞—à–∞—Ç–∞ —Å–∫—Ä–æ–º–Ω–∞ –ø–ª–∞–Ω–µ—Ç–∞ –æ—Ç –≥–æ–ª–µ–º–∏—è, –Ω–µ–æ–±—è—Ç–µ–Ω –ö–æ—Å–º–æ—Å.

–í —Å—ä—â–æ—Ç–æ –≤—Ä–µ–º–µ –æ—â–µ –æ—Ç –º–æ–º–µ–Ω—Ç–∞, –≤ –∫–æ–π—Ç–æ –∑–∞ –ø—Ä—ä–≤ –ø—ä—Ç –≤ –æ—á–∏—Ç–µ –Ω–∞ —Ö–æ–º–æ —Å–∞–ø–∏–µ–Ω—Å –µ –ø—Ä–æ–±–ª–µ—Å–Ω–∞–ª–∞ –∏—Å–∫—Ä–∞ –Ω–∞ –∏–Ω—Ç–µ–ª–∏–≥–µ–Ω—Ç–Ω–æ—Å—Ç, —Ç–æ–π –µ –æ—Ç–ø—Ä–∞–≤–∏–ª –∂–∞–¥–µ–Ω –ø–æ–≥–ª–µ–¥ –∫—ä–º –∑–≤–µ–∑–¥–∏—Ç–µ –∏ –µ –∑–∞–ø–æ—á–Ω–∞–ª –¥–∞ —Å–∏ –∑–∞–¥–∞–≤–∞ –≤—ä–ø—Ä–æ—Å–∏ –∑–∞ —Ç—è—Ö. –ö–∞–∫–≤–æ —Å–∞ —Ç–µ? –ö–æ–ª–∫–æ –¥–∞–ª–µ—á —Å–µ –Ω–∞–º–∏—Ä–∞—Ç? –û—Ç –∫–∞–∫–≤–æ —Å–∞ –∏–∑–≥—Ä–∞–¥–µ–Ω–∏? –ö–∞–∫ —Ç–∞–∫–∞ –≤–∏—Å—è—Ç –Ω–µ–∑–∞–∫—Ä–µ–ø–µ–Ω–∏ –≤ –Ω–µ–±–µ—Ç–æ –∏ –Ω–µ –ø–∞–¥–∞—Ç?

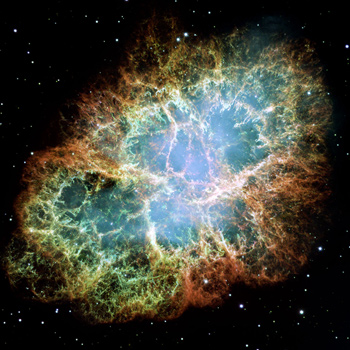

–í –∑–æ—Ä–∞—Ç–∞ –Ω–∞ —Ü–∏–≤–∏–ª–∏–∑–∞—Ü–∏—è—Ç–∞ –æ—Ç–≥–æ–≤–æ—Ä–∏—Ç–µ –Ω–∞ —Ç–µ–∑–∏ –≤—ä–ø—Ä–æ—Å–∏ —Å–∞ –±–∏–ª–∏ –ª–µ—Å–Ω–∏ – –≤—Å–µ –æ—â–µ –ø—Ä–æ—Å—Ç–æ —É—Å—Ç—Ä–æ–µ–Ω–∏—è—Ç –º–æ–∑—ä–∫ –Ω–∞ –¥–∞–ª–µ—á–Ω–∏—Ç–µ –Ω–∏ –ø—Ä–∞–¥–µ–¥–∏ –Ω–µ –µ –±–∏–ª —Å–∫–ª–æ–Ω–µ–Ω –¥–∞ –æ—Å–º–∏—Å–ª–∏ –∏ –≤—ä–∑–ø—Ä–∏–µ–º–µ –ø–æ-—Å–ª–æ–∂–Ω–∏—Ç–µ —Ä–µ–∞–ª–Ω–æ—Å—Ç–∏ –Ω–∞ –∞—Å—Ç—Ä–æ—Ñ–∏–∑–∏–∫–∞—Ç–∞. –° –≤—Ä–µ–º–µ—Ç–æ –æ–±–∞—á–µ –∏ —Å –Ω–∞—Ç—Ä—É–ø–≤–∞–Ω–µ—Ç–æ –Ω–∞ —Å—ä–≤–∫—É–ø–Ω–æ—Ç–æ —á–æ–≤–µ—à–∫–æ –ø–æ–∑–Ω–∞–Ω–∏–µ –Ω–µ—â–∞—Ç–∞ –∑–∞–ø–æ—á–Ω–∞–ª–∏ –¥–∞ –∏–∑–≥–ª–µ–∂–¥–∞—Ç –≤—Å–µ –ø–æ-—Å–ª–æ–∂–Ω–∏ –∏ –ø–æ-—Å–ª–æ–∂–Ω–∏. –ü–æ—è–≤–∏–ª–∏ —Å–µ –ø–æ–Ω—è—Ç–∏—è –∑–∞ —Ç—Ä—É–¥–Ω–æ –æ–±—è—Å–Ω–∏–º–∏ —è–≤–ª–µ–Ω–∏—è –∏ —Ñ–µ–Ω–æ–º–µ–Ω–∏ –∫–∞—Ç–æ —á–µ—Ä–Ω–∏ –¥—É–ø–∫–∏, —Ç—ä–º–Ω–∞ –º–∞—Ç–µ—Ä–∏—è, —Ç–∞—Ö–∏–æ–Ω–∏ –∏ –¥—Ä—É–≥–∏ –µ–ª–µ–º–µ–Ω—Ç–∞—Ä–Ω–∏ —á–∞—Å—Ç–∏—Ü–∏ –∏ –≤—Å–∏—á–∫–æ —Ç–æ–≤–∞ –ø–æ—Å—Ç–µ–ø–µ–Ω–Ω–æ —Ä–∏—Å—É–≤–∞–ª–æ –µ–¥–Ω–∞ –∫–∞—Ä—Ç–∏–Ω–∞ –Ω–∞ –ö–æ—Å–º–æ—Å–∞, –ø–æ-—Å–ª–æ–∂–Ω–∞, –æ—Ç–∫–æ–ª–∫–æ—Ç–æ –Ω—è–∫–æ–π –Ω—è–∫–æ–≥–∞ —Å–∏ –µ –ø—Ä–µ–¥—Å—Ç–∞–≤—è–ª.

–í—ä–≤ –≤—Ä–µ–º–µ—Ç–æ –Ω–∞ –ì–∞–ª–∏–ª–µ–π –∏ –ö–æ–ø–µ—Ä–Ω–∏–∫ –∑–∞ –ø–æ–¥–±–æ—Ä–∞, –æ–±—Ä–∞–±–æ—Ç–∫–∞—Ç–∞ –∏ —Å–æ—Ä—Ç–∏—Ä–∞–Ω–µ—Ç–æ –Ω–∞ —Ç–∞–∑–∏ –∏–Ω—Ñ–æ—Ä–º–∞—Ü–∏—è —É—á–µ–Ω–∏—Ç–µ, —Ä–∞–∑–±–∏—Ä–∞ —Å–µ, —Ä–∞–∑—á–∏—Ç–∞–ª–∏ –æ—Å–Ω–æ–≤–Ω–æ –Ω–∞ —Å–µ–±–µ —Å–∏ –∏ –Ω–∞ —Å–≤–æ—è —É–º. –¢–æ–≤–∞ –µ –∏ –µ–¥–Ω–∞ –æ—Ç –ø—Ä–∏—á–∏–Ω–∏—Ç–µ —Ç–æ–≥–∞–≤–∞ –Ω–æ–≤–∏—Ç–µ –æ—Ç–∫—Ä–∏—Ç–∏—è –∑–∞ —Å—ä—â–Ω–æ—Å—Ç—Ç–∞ –Ω–∞ –ö–æ—Å–º–æ—Å–∞ –∏ –Ω–∞—á–∏–Ω–∞, –ø–æ –∫–æ–π—Ç–æ —Ä–∞–±–æ—Ç–∏ –í—Å–µ–ª–µ–Ω–∞—Ç–∞, –¥–∞ —Å–µ —Å–ª—É—á–≤–∞–ª–∏ –±–∞–≤–Ω–æ –∏ –¥–∞ —Å–µ –≤—ä–∑–ø—Ä–∏–µ–º–∞–ª–∏ —Ç—Ä—É–¥–Ω–æ. –í –∑–æ—Ä–∞—Ç–∞ –Ω–∞ –•–• –≤–µ–∫ –æ–±–∞—á–µ –∏ –æ—Å–æ–±–µ–Ω–æ –≤ –∫—Ä–∞—è –Ω–∞ 70-—Ç–µ –º—É –≥–æ–¥–∏–Ω–∏ –µ–¥–Ω–æ –Ω–æ–≤–æ —á–æ–≤–µ—à–∫–æ –∏–∑–æ–±—Ä–µ—Ç–µ–Ω–∏–µ –ø—Ä–æ–º–µ–Ω–∏–ª–æ –ø—Ä–∞–≤–∏–ª–∞—Ç–∞ –Ω–∞ –∏–≥—Ä–∞—Ç–∞ –≤ —Å—Ñ–µ—Ä–∞—Ç–∞ –Ω–∞ –∫–æ—Å–º–∏—á–µ—Å–∫–∏—Ç–µ –∏–∑—Å–ª–µ–¥–≤–∞–Ω–∏—è.

–ü–æ—è–≤–∞—Ç–∞ –∏ –º–∞—Å–æ–≤–æ—Ç–æ —Ä–∞–∑–ø—Ä–æ—Å—Ç—Ä–∞–Ω–µ–Ω–∏–µ –Ω–∞ —Ç–∞–∫–∞ –Ω–∞—Ä–µ—á–µ–Ω–∏—Ç–µ –µ–ª–µ–∫—Ç—Ä–æ–Ω–Ω–∏ –∏–∑—á–∏—Å–ª–∏—Ç–µ–ª–Ω–∏ –º–∞—à–∏–Ω–∏ (–∏–ª–∏ –ø–æ-–ø—Ä–æ—Å—Ç–æ –∫–∞–∑–∞–Ω–æ –∫–æ–º–ø—é—Ç—Ä–∏) –¥–∞–ª–æ –≤ —Ä—ä—Ü–µ—Ç–µ –Ω–∞ –∞—Å—Ç—Ä–æ—Ñ–∏–∑–∏—Ü–∏ –∏ –∞—Å—Ç—Ä–æ–Ω–æ–º–∏ –º–æ—â–µ–Ω –Ω–æ–≤ –∏–Ω—Å—Ç—Ä—É–º–µ–Ω—Ç –∑–∞ –æ–±—Ä–∞–±–æ—Ç–∫–∞ –Ω–∞ –æ–≥—Ä–æ–º–Ω–æ—Ç–æ –∫–æ–ª–∏—á–µ—Å—Ç–≤–æ –¥–∞–Ω–Ω–∏, —Å –∫–æ–∏—Ç–æ –Ω–∏ –∑–∞–ª–∏–≤–∞ –í—Å–µ–ª–µ–Ω–∞—Ç–∞. –Ý–∞–¥–∏–æ—Å–∏–≥–Ω–∞–ª–∏ –æ—Ç –¥—ä–ª–±–æ–∫–∏—è –ö–æ—Å–º–æ—Å, —Ç–µ–ª–µ–º–µ—Ç—Ä–∏—á–Ω–∏ –¥–∞–Ω–Ω–∏ –∑–∞ –ø–ª–∞–Ω–µ—Ç–∞—Ä–Ω–∏—Ç–µ –æ—Ä–±–∏—Ç–∏, –∏–∑–º–µ—Ä–≤–∞–Ω–∏—è –∑–∞ —Ü–∏–∫–ª–∏—á–Ω–æ—Ç–æ –¥–≤–∏–∂–µ–Ω–∏–µ –Ω–∞ –Ω–µ–±–µ—Å–Ω–∏—Ç–µ —Ç–µ–ª–∞ – –≤—Å–∏—á–∫–∏ —Ç–µ–∑–∏ —Å–ª–æ–∂–Ω–∏, –æ–≥—Ä–æ–º–Ω–∏ –ø–æ –æ–±–µ–º –∏–∑—á–∏—Å–ª–µ–Ω–∏—è –≤–µ—á–µ –Ω–µ –±–∏–ª–æ –Ω—É–∂–Ω–æ –¥–∞ —Å–µ –∏–∑–≤—ä—Ä—à–≤–∞—Ç „–Ω–∞ —Ä—ä–∫–∞”.

–¢–∞–∫–∞ –æ–ø–µ—Ä–∞—Ü–∏–∏, –∫–æ–∏—Ç–æ —Å–∞–º–æ –¥–æ–ø—Ä–µ–¥–∏ 50 –≥–æ–¥–∏–Ω–∏ –æ—Ç–Ω–µ–º–∞–ª–∏ –º–µ—Å–µ—Ü–∏, —Å–µ –∏–∑–≤—ä—Ä—à–≤–∞–ª–∏ –∑–∞ —á–∞—Å–æ–≤–µ. –í –∫—Ä–∞–π–Ω–∞ —Å–º–µ—Ç–∫–∞ —Ä–∞–∑–≤–∏—Ç–∏–µ—Ç–æ –Ω–∞ –≤–∏—Å–æ–∫–∏—Ç–µ —Ç–µ—Ö–Ω–æ–ª–æ–≥–∏–∏ –∏ —Å–µ—Ä–∏–æ–∑–Ω–∏—è—Ç –Ω–∞–ø—Ä–µ–¥—ä–∫ –≤ –∏–∑—Å–ª–µ–¥–≤–∞–Ω–µ—Ç–æ –Ω–∞ –ö–æ—Å–º–æ—Å–∞ –∏ –í—Å–µ–ª–µ–Ω–∞—Ç–∞ –∏–∑–æ–±—â–æ —Å–∞ –Ω–µ—Ä–∞–∑—Ä–∏–≤–Ω–æ —Å–≤—ä—Ä–∑–∞–Ω–∏. –í —Ç–æ–∑–∏ –∫—Ä–∞—Ç—ä–∫ –º–∞—Ç–µ—Ä–∏–∞–ª —â–µ —Å–µ –æ–ø–∏—Ç–∞–º–µ –¥–∞ –Ω–∞–º–µ—Ä–∏–º –æ—Ç–≥–æ–≤–æ—Ä –Ω–∞ –≤—ä–ø—Ä–æ—Å–∞, –∫–∞–∫ –∏ –∫–æ–ª–∫–æ —Ç–æ—á–Ω–æ.

–°–∫—Ä–æ–º–Ω–∏—Ç–µ —Ç—Ä—É–∂–µ–Ω–∏—Ü–∏ –≤—ä–≤ –≤–∏—Å–æ–∫–∞ –æ—Ä–±–∏—Ç–∞...

–°–ª–µ–¥ –ø–æ–¥–æ–±–µ–Ω —É–≤–æ–¥ –≤–µ—Ä–æ—è—Ç–Ω–æ –æ—á–∞–∫–≤–∞—Ç–µ –¥–∞ –∑–∞–ø–æ—á–Ω–µ–º –Ω–∞—à–∏—è —Ä–∞–∑–∫–∞–∑ —Å –ø—Ä–∏–º–µ—Ä–∏ –∑–∞ —É–ª—Ç—Ä–∞–º–æ—â–Ω–∞ —Ç–µ—Ö–Ω–æ–ª–æ–≥–∏—è, –∑–∞ –ø—Ä–æ—Ü–µ—Å–æ—Ä–∏ —Å –ø–æ 8 - 12 —è–¥—Ä–∞, –∑–∞ —Å—É–ø–µ—Ä–∫–æ–º–ø—é—Ç—Ä–∏, –∏–∑–≥—Ä–∞–¥–µ–Ω–∏ –æ—Ç –æ–≥—Ä–æ–º–Ω–∏ –º–∞—Å–∏–≤–∏ –æ—Ç —Ä–∞–±–æ—Ç–Ω–∏ —Å—Ç–∞–Ω—Ü–∏–∏, –∏–∑–ø–æ–ª–∑–≤–∞—â–∏ Opteron –∏–ª–∏ Xeon —á–∏–ø–æ–≤–µ –æ—Ç –ø–æ—Å–ª–µ–¥–Ω–∞ –≥–µ–Ω–µ—Ä–∞—Ü–∏—è. –ù–∏—â–æ –ø–æ–¥–æ–±–Ω–æ! –©–µ –∑–∞–ø–æ—á–Ω–µ–º —Å –Ω–µ—â–æ –¥–∞–ª–µ—á –ø–æ-–ø—Ä–æ—Å—Ç–æ. –° –µ–¥–∏–Ω  —á–∏–ø, –∑–∞ –∫–æ–π—Ç–æ –¥–Ω–µ—à–Ω–æ—Ç–æ —Å–º–∞—Ä—Ç—Ñ–æ–Ω –ø–æ–∫–æ–ª–µ–Ω–∏–µ –≤–µ—Ä–æ—è—Ç–Ω–æ –¥–æ—Ä–∏ –Ω–µ –µ —á—É–≤–∞–ª–æ – –∑–∞ –¥–æ–±—Ä–∏—è —Å—Ç–∞—Ä Intel 80486, –∏–ª–∏ –∫–∞–∫—Ç–æ —Å–∏ –≥–æ –∑–Ω–∞–µ—Ö–º–µ –ø—Ä–µ–∑ 90-—Ç–µ –≥–æ–¥–∏–Ω–∏ –Ω–∞ –º–∏–Ω–∞–ª–∏—è –≤–µ–∫ – 486-–∏—Ü–∞.

—á–∏–ø, –∑–∞ –∫–æ–π—Ç–æ –¥–Ω–µ—à–Ω–æ—Ç–æ —Å–º–∞—Ä—Ç—Ñ–æ–Ω –ø–æ–∫–æ–ª–µ–Ω–∏–µ –≤–µ—Ä–æ—è—Ç–Ω–æ –¥–æ—Ä–∏ –Ω–µ –µ —á—É–≤–∞–ª–æ – –∑–∞ –¥–æ–±—Ä–∏—è —Å—Ç–∞—Ä Intel 80486, –∏–ª–∏ –∫–∞–∫—Ç–æ —Å–∏ –≥–æ –∑–Ω–∞–µ—Ö–º–µ –ø—Ä–µ–∑ 90-—Ç–µ –≥–æ–¥–∏–Ω–∏ –Ω–∞ –º–∏–Ω–∞–ª–∏—è –≤–µ–∫ – 486-–∏—Ü–∞.

–•–æ—Ä–∞—Ç–∞, –∫–æ–∏—Ç–æ –¥–Ω–µ—Å —Å–∞ —Å–≤–∏–∫–Ω–∞–ª–∏ –¥–∞ –∏–º–∞—Ç –ø—Ä–æ—Ü–µ—Å–æ—Ä–∏ —Å –¥–≤–µ –∏ –¥–æ—Ä–∏ —Å —á–µ—Ç–∏—Ä–∏ —è–¥—Ä–∞ –≤ –º–æ–±–∏–ª–Ω–∏—Ç–µ —Å–∏ —Ç–µ–ª–µ—Ñ–æ–Ω–∏, –µ–¥–≤–∞ –ª–∏ —Å–∏ —Å–ø–æ–º–Ω—è—Ç –≤—Ä–µ–º–µ–Ω–∞—Ç–∞, –≤ –∫–æ–∏—Ç–æ –ø–æ–≤–∏—à–µ–Ω–∏–µ –Ω–∞ —Ç–∞–∫—Ç–æ–≤–∞—Ç–∞ —á–µ—Å—Ç–æ—Ç–∞ —Å 8 MHz –±–µ—à–µ –≥–æ–ª—è–º–∞ —Ä–∞–±–æ—Ç–∞, –∞ –∑–∞ –¥–∞ —Å–∏ –ø–æ–∑–≤–æ–ª–∏—à –æ—â–µ 1 –ú–í –æ–ø–µ—Ä–∞—Ç–∏–≤–Ω–∞ –ø–∞–º–µ—Ç, —Ç—Ä—è–±–≤–∞—à–µ –¥–∞ —Å–ø–µ—Å—Ç—è–≤–∞—à –ø–æ–Ω–µ 1 –≥–æ–¥–∏–Ω–∞, —Ç—ä–π –∫–∞—Ç–æ —Ç—è —Å—Ç—Ä—É–≤–∞—à–µ —Ä–∞–∑–æ—Ä–∏—Ç–µ–ª–Ω–∏—Ç–µ 200 –¥–æ–ª–∞—Ä–∞.

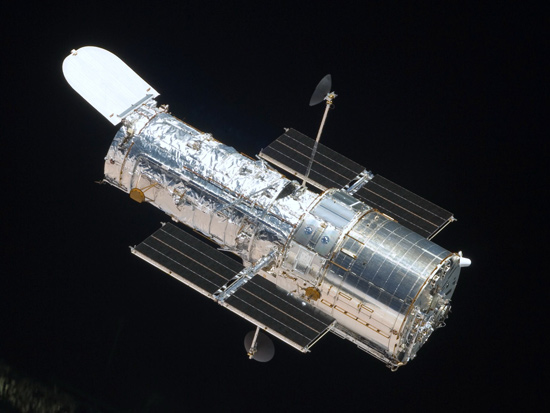

–ü–æ–¥–æ–±–Ω–∏ —Ç–µ—Ö–Ω–æ–ª–æ–≥–∏—á–Ω–∏ „—á—É–¥–µ—Å–∞” –º–æ–∂–µ –¥–∞ –∏–∑–≥–ª–µ–∂–¥–∞—Ç —Å–º–µ—à–Ω–∏ –æ—Ç –≥–ª–µ–¥–Ω–∞ —Ç–æ—á–∫–∞ –Ω–∞ –Ω–∞—à–µ—Ç–æ —Å—ä–≤—Ä–µ–º–∏–µ, –Ω–æ –∏–º–µ–Ω–Ω–æ –µ–¥–Ω–æ —Ç–∞–∫–æ–≤–∞ „—á—É–¥–æ” –≤—Å–µ –æ—â–µ —É–ø—Ä–∞–≤–ª—è–≤–∞ –µ–¥–∏–Ω –æ—Ç –Ω–∞–π-—É–¥–∏–≤–∏—Ç–µ–ª–Ω–∏—Ç–µ –∏–Ω—Å—Ç—Ä—É–º–µ–Ω—Ç–∏ –∑–∞ –Ω–∞–±–ª—é–¥–µ–Ω–∏–µ –∏ –∏–∑—Å–ª–µ–¥–≤–∞–Ω–µ –Ω–∞ –ö–æ—Å–º–æ—Å–∞ – —Ç–µ–ª–µ—Å–∫–æ–ø–∞ –•—ä–±—ä–ª.

–í—Å—ä—â–Ω–æ—Å—Ç —Ñ–∞–∫—Ç–∏—Ç–µ —Å–∞ —Ç–∞–∫–∏–≤–∞

–ë–æ–ª—à–∏–Ω—Å—Ç–≤–æ—Ç–æ –ø–æ–¥–æ–±–Ω–∏ —É—Ä–µ–¥–∏ –¥–Ω–µ—Å –æ–ø–µ—Ä–∏—Ä–∞—Ç —Å –∂–∞–ª–∫–∏ –ø–æ —Å—ä–≤—Ä–µ–º–µ–Ω–Ω–∏—Ç–µ —Å—Ç–∞–Ω–¥–∞—Ä—Ç–∏ –ø—Ä–æ—Ü–µ—Å–æ—Ä–Ω–∏ –º–æ—â–Ω–æ—Å—Ç–∏. –ö–æ–º–ø—é—Ç—Ä–∏—Ç–µ –Ω–∞ –±–æ—Ä–¥–∞ –Ω–∞ –ú–µ–∂–¥—É–Ω–∞—Ä–æ–¥–Ω–∞—Ç–∞ –∫–æ—Å–º–∏—á–µ—Å–∫–∞ —Å—Ç–∞–Ω—Ü–∏—è –Ω–∞–ø—Ä–∏–º–µ—Ä –∏–∑–ø–æ–ª–∑–≤–∞—Ç 386 –ø—Ä–æ—Ü–µ—Å–æ—Ä–∞ (–ø—Ä–∏ —Ç–æ–≤–∞ –≤ –∫–æ–º–ø–ª–µ–∫—Ç —Å 387 –º–∞—Ç–µ–º–∞—Ç–∏—á–µ—Å–∫–∏ –∫–æ–ø—Ä–æ—Ü–µ—Å–æ—Ä–∞), –∫–æ–∏—Ç–æ –¥–Ω–µ—Å, —á–µ—Å—Ç–Ω–æ –∫–∞–∑–∞–Ω–æ, –º–æ–≥–∞—Ç –¥–∞ —Å–µ –Ω–∞–º–µ—Ä—è—Ç –Ω–∞–π-–≤–µ—á–µ –∏ –æ—Å–Ω–æ–≤–Ω–æ –≤ –∏—Å—Ç–æ—Ä–∏—á–µ—Å–∫–∏—Ç–µ –º—É–∑–µ–∏.

–•—ä–±—ä–ª –æ—Ç –¥—Ä—É–≥–∞ —Å—Ç—Ä–∞–Ω–∞, –∫–æ–π—Ç–æ –≤—Å–µ –æ—â–µ –µ –µ–¥–∏–Ω –æ—Ç –æ—Å–Ω–æ–≤–Ω–∏—Ç–µ –∏–∑—Ç–æ—á–Ω–∏—Ü–∏ –Ω–∞ –Ω—è–∫–æ–∏ –æ—Ç –Ω–∞–π-—Å–º–∞–π–≤–∞—â–∏—Ç–µ –∫–æ—Å–º–∏—á–µ—Å–∫–∏ –æ—Ç–∫—Ä–∏—Ç–∏—è –Ω–∞ –Ω–∞—à–µ—Ç–æ –≤—Ä–µ–º–µ, –º–∞–∫–∞—Ä –¥–∞ –∏–∑–ø–æ–ª–∑–≤–∞ 486 —á–∏–ø, –≤—Å—ä—â–Ω–æ—Å—Ç —Å–µ —Å–¥–æ–±–∏ —Å –Ω–µ–≥–æ –≤—Å–ª–µ–¥—Å—Ç–≤–∏–µ –Ω–∞ —Ç—Ä–µ—Ç–∏ –ø–ª–∞–Ω–æ–≤ —ä–ø–≥—Ä–µ–π–¥ –Ω–∞ –±–æ—Ä–¥–æ–≤–∏—è—Ç —Å–∏ –∫–æ–º–ø—é—Ç—ä—Ä. –ö–æ–≥–∞—Ç–æ –±–µ—à–µ –∏–∑—Å—Ç—Ä–µ–ª—è–Ω –≤ –æ–∫–æ–ª–æ–∑–µ–º–Ω–∞ –æ—Ä–±–∏—Ç–∞, —Ç–æ–π —Ä–∞–∑—á–∏—Ç–∞—à–µ –Ω–∞ —É–Ω–∏–∫–∞–ª–Ω–∞ –∫–æ–º–ø—é—Ç—ä—Ä–Ω–∞ —Å–∏—Å—Ç–µ–º–∞, —Ä–∞–∑—Ä–∞–±–æ—Ç–µ–Ω–∞ –æ—Ç Rockwell International. –ù–µ–π–Ω–æ—Ç–æ –∏–º–µ –µ DF-224, –∞ —É—Å—Ç—Ä–æ–π—Å—Ç–≤–æ—Ç–æ –π e –º–µ–∫–æ –∫–∞–∑–∞–Ω–æ, –Ω–µ—Å—Ç–∞–Ω–¥–∞—Ä—Ç–Ω–æ. –¢–∞–∫–∞ –Ω–∞–ø—Ä–∏–º–µ—Ä —Ç—è –±–µ—à–µ –∏–∑–≥—Ä–∞–¥–µ–Ω–∞ –æ—Ç 2-–±–∏—Ç–æ–≤–∏ —Å–µ–≥–º–µ–Ω—Ç–∏, –∫–æ–∏—Ç–æ, —Å—ä—á–µ—Ç–∞–Ω–∏ –≤ –∫–æ–º–ø–ª–µ–∫—Ç –æ—Ç 8 —á–∞—Å—Ç–∏, —Å—ä—Å—Ç–∞–≤–ª—è–≤–∞—Ö–∞ –∫–ª–∞—Å–∏—á–µ—Å–∫–∏ 16-–±–∏—Ç–æ–≤ –∫–æ–º–ø—é—Ç—ä—Ä. DF-224 –æ—Å–≤–µ–Ω —Ç–æ–≤–∞ –Ω–µ —Ä–∞–∑–ø–æ–ª–∞–≥–∞—à–µ —Å –∫–ª–∞—Å–∏—á–µ—Å–∫–∏ —á–∏–ø–æ–≤–µ –ø–∞–º–µ—Ç, –∏–∑—Ä–∞–±–æ—Ç–µ–Ω–∏ –æ—Ç —Å–∏–ª–∏—Ü–∏–π, –∞ –∏–∑–ø–æ–ª–∑–≤–∞—à–µ —Ä–∞–∑–ª–∏—á–µ–Ω –º–µ—Ö–∞–Ω–∏–∑—ä–º –∑–∞ —Å—ä—Ö—Ä–∞–Ω–µ–Ω–∏–µ –Ω–∞ –æ–ø–µ—Ä–∞—Ç–∏–≤–Ω–∞ –∏–Ω—Ñ–æ—Ä–º–∞—Ü–∏—è. –ù–∞ —Ñ–∏–Ω–∞–ª–∞ –ª–æ–≥–∏–∫–∞—Ç–∞ –Ω–∞ „—Ü–µ–Ω—Ç—Ä–∞–ª–Ω–∏—è –π –ø—Ä–æ—Ü–µ—Å–æ—Ä” –¥–æ—Ä–∏ –Ω–µ –±–µ—à–µ –º–∞—Å–æ–≤–∞—Ç–∞ –≤ –º–æ–º–µ–Ω—Ç–∞ CMOS (Complementary metal–oxide–semiconductor), a PMOS (P-type metal-oxide-semiconductor) – –º–Ω–æ–≥–æ —Ä–∞–Ω–µ–Ω –Ω–µ–∏–Ω –ø—Ä–µ–¥—à–µ—Å—Ç–≤–µ–Ω–∏–∫, –∫–æ–π—Ç–æ –æ—Å–≤–µ–Ω –≤—Å–∏—á–∫–æ –¥—Ä—É–≥–æ –∫–æ–Ω—Å—É–º–∏—Ä–∞ —á—É–¥–æ–≤–∏—â–Ω–æ –∫–æ–ª–∏—á–µ—Å—Ç–≤–æ –µ–Ω–µ—Ä–≥–∏—è –∏ –≤ –Ω–∞—á–∞–ª–æ—Ç–æ –Ω–∞ –º–∏—Å–∏—è—Ç–∞ –µ —Å—ä–∑–¥–∞–≤–∞–ª–∞ –¥–æ—Å—Ç–∞ –ø—Ä–æ–±–ª–µ–º–∏ —Å –æ—Ö–ª–∞–∂–¥–∞–Ω–µ—Ç–æ –Ω–∞ –•—ä–±—ä–ª.

–í—Å—ä—â–Ω–æ—Å—Ç, –∞–∫–æ —Å–µ –∑–∞–º–∏—Å–ª–∏—Ç–µ, –∏ —Å–∞–º–∏ —â–µ —Å—Ç–∏–≥–Ω–µ—Ç–µ –¥–æ –∏–∑–≤–æ–¥–∞, —á–µ –Ω–∞–ª–∏—á–∏–µ—Ç–æ –Ω–∞ –ø–æ–¥–æ–±–Ω–∏ –¥–æ—Å—Ç–∞ –∞—Ä—Ö–∞–∏—á–Ω–∏ –∫–æ–º–ø—é—Ç—ä—Ä–Ω–∏ —Ç–µ—Ö–Ω–æ–ª–æ–≥–∏–∏ –≤ —Ä–∞–∑–ª–∏—á–Ω–∏—Ç–µ –∫–æ—Å–º–∏—á–µ—Å–∫–∏ –∞–ø–∞—Ä–∞—Ç–∏ –µ –ø–ª–æ–¥ –Ω–∞ –∑–¥—Ä–∞–≤–∞ –ª–æ–≥–∏–∫–∞. –û—Ç –µ–¥–Ω–∞ —Å—Ç—Ä–∞–Ω–∞, –∏–∑—á–∏—Å–ª–µ–Ω–∏—è—Ç–∞, —Å –∫–æ–∏—Ç–æ —Å–∞ –Ω–∞—Ç–æ–≤–∞—Ä–µ–Ω–∏ —Ç–µ, —Å–∞ –æ—Ç –∫—Ä–∏—Ç–∏—á–Ω–æ –∑–Ω–∞—á–µ–Ω–∏–µ, –Ω–æ –Ω–µ —Å–∞ —á–∞–∫ —Ç–æ–ª–∫–æ–≤–∞ —Ç–µ–∂–∫–∏ –∏ –æ–±–µ–º–∏—Å—Ç–∏. –ù–∞ –ø—Ä–∞–∫—Ç–∏–∫–∞ –±–æ—Ä–¥–æ–≤–∏—è—Ç –∫–æ–º–ø—é—Ç—ä—Ä –Ω–∞ –•—ä–±—ä–ª –Ω–µ –∏–∑–≤—ä—Ä—à–≤–∞ –ø–æ-—Ä–∞–∑–ª–∏—á–Ω–∏ –æ–ø–µ—Ä–∞—Ü–∏–∏ –æ—Ç –∫–æ–π –¥–∞ –µ –¥—Ä—É–≥ –±–æ—Ä–¥–æ–≤–∏ –∫–æ–º–ø—é—Ç—ä—Ä – –Ω–µ–≥–æ–≤–∏—Ç–µ –∑–∞–¥–∞—á–∏ —Å–∞ —Å–≤—ä—Ä–∑–∞–Ω–∏ —Å—ä—Å —Å–ª–µ–¥–µ–Ω–µ –Ω–∞ –¥–∞–Ω–Ω–∏—Ç–µ –æ—Ç —Å–µ—Ä–∏—è –¥–∞—Ç—á–∏—Ü–∏ – –∑–∞ —Ç–µ–º–ø–µ—Ä–∞—Ç—É—Ä–∞, —Å–∫–æ—Ä–æ—Å—Ç, –≤–∏—Å–æ—á–∏–Ω–∞ –∏ –ø—Ä–µ–¥–∞–≤–∞–Ω–µ—Ç–æ –∏–º –∫—ä–º –Ω–∞–∑–µ–º–Ω–∏—Ç–µ –∫–æ–Ω—Ç—Ä–æ–ª–Ω–∏ —Å–∏—Å—Ç–µ–º–∏. –°–ª–µ–¥ —Ç–æ–≤–∞ —Ç–æ–π —Ç—Ä—è–±–≤–∞ –¥–∞ –ø—Ä–∏–µ–º–µ –∫–æ–º–∞–Ω–¥–∏—Ç–µ, –∏–∑–ø—Ä–∞—Ç–µ–Ω–∏ –æ—Ç –Ω–∞–∑–µ–º–Ω–∏—è –µ–∫–∏–ø, –∏ –¥–∞ –≥–∏ –æ—Å—ä—â–µ—Å—Ç–≤–∏. –¢–∞–∫–∞ –Ω–∞ –ø—Ä–∞–∫—Ç–∏–∫–∞ –±–æ—Ä–¥–æ–≤–∏—è—Ç –∫–æ–º–ø—é—Ç—ä—Ä –Ω–∞ –µ–¥–∏–Ω –∫–æ—Å–º–∏—á–µ—Å–∫–∏ —Å—ä–¥ –∫–∞—Ç–æ –•—ä–±—ä–ª –∏–∑–ø—ä–ª–Ω—è–≤–∞ –ø–æ–≤–µ—á–µ —Ä–æ–ª—è—Ç–∞ –Ω–∞ —Ç–µ—Ä–º–∏–Ω–∞–ª, –∞ –º–Ω–æ–∑–∏–Ω—Å—Ç–≤–æ—Ç–æ –∫–æ–º–ø–ª–µ–∫—Å–Ω–∏ –∏–∑—á–∏—Å–ª–µ–Ω–∏—è —Å–µ –∏–∑–≤—ä—Ä—à–≤–∞—Ç –æ—Ç –∫–æ–Ω—Ç—Ä–æ–ª–Ω–∏—Ç–µ —Å–∏—Å—Ç–µ–º–∏ –Ω–∞ –ó–µ–º—è—Ç–∞.

–¢–æ—á–Ω–æ –∑–∞—Ç–æ–≤–∞ –ø—Ä–∏ –∏–∑–±–æ—Ä–∞ –Ω–∞ —á–∏–ø–æ–≤–µ —É—á–µ–Ω–∏—Ç–µ, –µ–∫–∏–ø–∏—Ä–∞—â–∏ –∏–Ω—Å—Ç—Ä—É–º–µ–Ω—Ç –∫–∞—Ç–æ –•—ä–±—ä–ª, —Å–µ —Ä—ä–∫–æ–≤–æ–¥—è—Ç –æ—Ç —Å—ä–≤—Å–µ–º —Ä–∞–∑–ª–∏—á–Ω–∏ —Å—ä–æ–±—Ä–∞–∂–µ–Ω–∏—è –æ—Ç —Ç–µ–∑–∏, –∫–æ–∏—Ç–æ –∏–º–∞–º–µ –Ω–∏–µ, –Ω–∞–ø—Ä–∏–º–µ—Ä –∫–æ–≥–∞—Ç–æ –∏–∑–±–∏—Ä–∞–º–µ –ø—Ä–æ—Ü–µ—Å–æ—Ä –∑–∞ –Ω–æ–≤–æ—Ç–æ —Å–∏ –¥–æ–º–∞—à–Ω–æ –Ý–°.

–¢–∞–∫–∞ –Ω–∞–ø—Ä–∏–º–µ—Ä –∑–∞ —Ç—è—Ö –µ –≤–∞–∂–Ω–æ —Å—ä–æ—Ç–≤–µ—Ç–Ω–∏—è—Ç —á–∏–ø –¥–∞ –±—ä–¥–µ —É—Å—Ç–æ–π—á–∏–≤ –Ω–∞ —Ä–∞–¥–∏–∞—Ü–∏—è –∏ —Ä–∞–¥–∏–∞—Ü–∏–æ–Ω–Ω–∏ –ª—ä—á–µ–Ω–∏—è, –Ω–∞ –∫–æ–∏—Ç–æ —Ç–æ–π —â–µ –±—ä–¥–µ –∏–∑–ª–æ–∂–µ–Ω –ø—Ä–∏ —Ä–∞–±–æ—Ç–∞—Ç–∞ —Å–∏ –≤ –æ—Ç–∫—Ä–∏—Ç–∏—è –ö–æ—Å–º–æ—Å. –ò–º–µ–Ω–Ω–æ —Ç–æ–≤–∞ –µ –µ–¥–Ω–∞ –æ—Ç –æ—Å–Ω–æ–≤–Ω–∏—Ç–µ –ø—Ä–∏—á–∏–Ω–∏ –∑–∞ –∏–∑–±–æ—Ä –Ω–∞ Intel 486 – –æ–∫–∞–∑–∞–ª–æ —Å–µ, —á–µ —Ç–æ–≤–∞ –µ –µ–¥–∏–Ω –æ—Ç –Ω–∞–π-—Ä–∞–¥–∏–∞—Ü–∏–æ–Ω–Ω–æ —É—Å—Ç–æ–π—á–∏–≤–∏—Ç–µ —á–∏–ø–æ–≤–µ, –Ω–∞–ª–∏—á–Ω–∏ –ø–æ –≤—Ä–µ–º–µ—Ç–æ, –∫–æ–≥–∞—Ç–æ –µ –±–∏–ª –ø–ª–∞–Ω–∏—Ä–∞–Ω –ø–æ—Å–ª–µ–¥–Ω–∏—è—Ç –æ–±—Å–ª—É–∂–≤–∞—â –ø–æ–ª–µ—Ç –¥–æ –•—ä–±—ä–ª.

... –∏ –º–æ–≥—ä—â–∏—Ç–µ –∏–º –Ω–∞–∑–µ–º–Ω–∏ –∫–æ–ª–µ–≥–∏

–¢–æ–≤–∞, —á–µ –¥–æ—Ä–∏ –∏ —Å–µ–≥–∞ –≤–∏—Å–æ–∫–æ –Ω–∞–¥ –Ω–∞—Å –æ–±–∏–∫–∞–ª—è—Ç –¥–µ—Å–µ—Ç–∫–∏ —Å—Ç–∞—Ü–∏–æ–Ω–∞—Ä–Ω–∏ —Å–ø—ä—Ç–Ω–∏—Ü–∏ –∏ –¥—Ä—É–≥–∏ –∫–æ—Å–º–∏—á–µ—Å–∫–∏ —Å—ä–¥–æ–≤–µ, –µ–∫–∏–ø–∏—Ä–∞–Ω–∏ —Å —Ç–µ—Ö–Ω–æ–ª–æ–≥–∏—è, –∫–æ—è—Ç–æ –µ –Ω–∞ –Ω–∞–π-–º–∞–ª–∫–æ 10 –≥–æ–¥–∏–Ω–∏ (—Ü—è–ª–∞ –µ—Ä–∞ –≤ —Å–≤–µ—Ç–∞ –Ω–∞ –º–∏–∫—Ä–æ–ø—Ä–æ—Ü–µ—Å–æ—Ä–∏—Ç–µ), –Ω–µ –æ–∑–Ω–∞—á–∞–≤–∞, —á–µ –≤—Å–∏—á–∫–∏ —É—á–µ–Ω–∏, –∑–∞–Ω–∏–º–∞–≤–∞—â–∏ —Å–µ —Å –∫–æ—Å–º–∏—á–µ—Å–∫–∏ –∏–∑—Å–ª–µ–¥–≤–∞–Ω–∏—è, –∏–∑–ø–æ–ª–∑–≤–∞—Ç –ø–æ–¥–æ–±–Ω–∏ –∞—Ä—Ö–∞–∏—á–Ω–∏ –∏–Ω—Å—Ç—Ä—É–º–µ–Ω—Ç–∏ –∑–∞ —Ä–∞–±–æ—Ç–∞—Ç–∞ —Å–∏. –¢–æ—á–Ω–æ –æ–±—Ä–∞—Ç–Ω–æ—Ç–æ!

E–¥–∏–Ω –æ—Ç –Ω–∞–π-–≤–ø–µ—á–∞—Ç–ª—è–≤–∞—â–∏—Ç–µ —Å—ä–≤—Ä–µ–º–µ–Ω–Ω–∏ –ø—Ä–∏–º–µ—Ä–Ω–∏ –≤ —Ç–æ–≤–∞ –æ—Ç–Ω–æ—à–µ–Ω–∏–µ –µ —Å—É–ø–µ—Ä-–∫–æ–º–ø—é—Ç—ä—Ä—ä—Ç –•–∏–¥—Ä–∞, –Ω–∞–º–∏—Ä–∞—â —Å–µ –æ–±—Å–µ—Ä–≤–∞—Ç–æ—Ä–∏—è—Ç–∞ –î–∂–æ—Ä–¥–µ–ª –ë–∞–Ω–∫ –∫—ä–º –£–Ω–∏–≤–µ—Ä—Å–∏—Ç–µ—Ç–∞ –ú–∞–Ω—á–µ—Å—Ç—ä—Ä. –° –Ω–µ–≥–æ–≤–∞ –ø–æ–º–æ—â (–∏ —Å –ø–æ–º–æ—â—Ç–∞ –Ω–∞ –º–æ—â–µ–Ω —Ä–∞–¥–∏–æ—Ç–µ–ª–µ—Å–∫–æ–ø) –∞—Å—Ç—Ä–æ–Ω–æ–º–∏—Ç–µ –∏–∑—Å–ª–µ–¥–≤–∞—Ç –æ—á–∞—Ä–æ–≤–∞—Ç–µ–ª–Ω–æ —Å—Ç—Ä–∞–Ω–Ω–æ—Ç–æ –ø–æ–≤–µ–¥–µ–Ω–∏–µ –Ω–∞ –ø—É–ª—Å–∞—Ä–∏—Ç–µ. –°—Ç–∞–≤–∞ –¥—É–º–∞ –∑–∞ –µ–¥–∏–Ω –æ—Ç –Ω–∞–π-–∑–∞–≥–∞–¥—ä—á–Ω–∏—Ç–µ –≤—Å–µ–ª–µ–Ω—Å–∫–∏ —Ñ–µ–Ω–æ–º–µ–Ω–∏ – –Ω–µ—É—Ç—Ä–æ–Ω–Ω–∏ –∑–≤–µ–∑–¥–∏, –∫–æ–∏—Ç–æ –∏–∑–ª—ä—á–≤–∞—Ç —Å–Ω–æ–ø–æ–≤–µ –µ–ª–µ–∫—Ç—Ä–æ–º–∞–≥–Ω–∏—Ç–Ω–∞ —Ä–∞–¥–∏–∞—Ü–∏—è —Å —Ç–æ—á–Ω–æ—Å—Ç—Ç–∞ –Ω–∞ –∞—Ç–æ–º–µ–Ω —á–∞—Å–æ–≤–Ω–∏–∫. –í—Å—ä—â–Ω–æ—Å—Ç —Ç–µ —Å–∞ —Ç–æ–ª–∫–æ–≤–∞ –Ω–µ—á–æ–≤–µ—à–∫–∏ —Ç–æ—á–Ω–∏, —á–µ „–∏–∑–æ—Å—Ç–∞–≤–∞—Ç” —Å –Ω–µ –ø–æ–≤–µ—á–µ –æ—Ç —Å–µ–∫—É–Ω–¥–∞ –Ω–∞ –Ω—è–∫–æ–ª–∫–æ –º–∏–ª–∏–æ–Ω–∞ –≥–æ–¥–∏–Ω–∏ – –Ω–µ—â–æ, –Ω–∞ –∫–æ–µ—Ç–æ Casio –º–æ–≥–∞—Ç —Å–∞–º–æ –¥–∞ –∑–∞–≤–∏–∂–¥–∞—Ç.

–•–∏–¥—Ä–∞ –µ —Å—ä–∑–¥–∞–¥–µ–Ω —Å–ø–µ—Ü–∏–∞–ª–Ω–æ –∑–∞ –Ω–∞–±–ª—é–¥–µ–Ω–∏–µ –ø–æ–≤–µ–¥–µ–Ω–∏–µ—Ç–æ –Ω–∞ –ø—É–ª—Å–∞—Ä–∏—Ç–µ –∏ –∑–∞ –¥–∞ –µ „–≤ –∫—Ä–∞–∫” —Å –∫–æ—Å–º–∏—á–µ—Å–∫–∞—Ç–∞ –∏–º –ø—Ä–µ—Ü–∏–∑–Ω–æ—Å—Ç, —Ç—è —Ä–∞–∑–ø–æ–ª–∞–≥–∞, –º–µ–∫–æ –∫–∞–∑–∞–Ω–æ, —Å –≤–ø–µ—á–∞—Ç–ª—è–≤–∞—â–∞ –∏–∑—á–∏—Å–ª–∏—Ç–µ–ª–Ω–∞ –º–æ—â. –ò–∑–≥—Ä–∞–¥–µ–Ω –µ –æ—Ç 180 –≤—ä–∑–µ–ª–∞, –≤—Å–µ–∫–∏ –±–∞–∑–∏—Ä–∞–Ω –Ω–∞ –¥–≤—É–ø—Ä–æ—Ü–µ—Å–æ—Ä–Ω–∞ –¥—ä–Ω–Ω–∞ –ø–ª–∞—Ç–∫–∞. –í—ä—Ä—Ö—É –Ω–µ—è —Å–∞ –∏–Ω—Å—Ç–∞–ª–∏—Ä–∞–Ω–∏ —á–∏—Ñ—Ç —á–µ—Ç–∏—Ä–∏—è–¥—Ä–µ–Ω–∏ Xeon —Å—É–ø–µ—Ä–ø—Ä–æ—Ü–µ—Å–æ—Ä–∞ —Å —Ç–∞–∫—Ç–æ–≤–∞ —á–µ—Å—Ç–æ—Ç–∞ 2.66 MHz –∏ 4 GB –æ–ø–µ—Ä–∞—Ç–∏–≤–Ω–∞ –ø–∞–º–µ—Ç.

–í–ø–µ—á–∞—Ç–ª—è–≤–∞—â–æ –Ω–∞–ª–∏? –ù–µ –∏ —Å–ø–æ—Ä–µ–¥ –¥–æ–∫—Ç–æ—Ä –ê–Ω—Ç—ä–Ω–∏ –•–æ–ª–æ—É–µ–π, –∑–∞–≤–µ–∂–¥–∞—â –∫–æ–º–ø—é—Ç—ä—Ä–Ω–∏—è –æ—Ç–¥–µ–ª –≤ –£–Ω–∏–≤–µ—Ä—Å–∏—Ç–µ—Ç–∞ –ú–∞–Ω—á–µ—Å—Ç—ä—Ä – –Ω–µ–æ—Ç–¥–∞–≤–Ω–∞ —Ç–æ–π –µ –ø–æ–¥–∞–ª –∑–∞—è–≤–∫–∞ –∑–∞ "—Å–∫—Ä–æ–º–µ–Ω —ä–ø–≥—Ä–µ–π–¥", –∫–æ–π—Ç–æ —â–µ —É–≤–µ–ª–∏—á–∏ –æ–±–µ–º–∞ –Ω–∞ –ø–∞–º–µ—Ç—Ç–∞ –∑–∞ –≤—Å–µ–∫–∏ –≤—ä–∑–µ–ª –¥–æ 8 GB.

–•–∏–¥—Ä–∞, —Ä–∞–∑–±–∏—Ä–∞ —Å–µ, —Å–µ –∏–∑–ø–æ–ª–∑–≤–∞ –∑–∞ –º–Ω–æ–≥–æ –∑–∞–¥–∞—á–∏, –Ω–æ –æ—Å–Ω–æ–≤–Ω–æ—Ç–æ –π –ø—Ä–µ–¥–Ω–∞–∑–Ω–∞—á–µ–Ω–∏–µ –µ –¥–∞ –∑–∞–ø–∏—Å–≤–∞ —Å –≤–∏—Å–æ–∫–∞ —Ç–æ—á–Ω–æ—Å—Ç –∏–Ω—Ç–µ—Ä–≤–∞–ª–∏—Ç–µ –º–µ–∂–¥—É –ø—É–ª—Å–∞—Ü–∏–∏—Ç–µ –Ω–∞ –Ω–∞–±–ª—é–¥–∞–≤–∞–Ω–∏—Ç–µ –æ—Ç —É—á–µ–Ω–∏—Ç–µ –Ω–µ—É—Ç—Ä–æ–Ω–Ω–∏ –∑–≤–µ–∑–¥–∏. –ó–∞ —Ü–µ–ª—Ç–∞ –∑–∞–ø–∏—Å—ä—Ç —Å–ª–µ–¥–≤–∞ –¥–∞ –±—ä–¥–µ —Å –∏–∑–∫–ª—é—á–∏—Ç–µ–ª–Ω–æ –≤–∏—Å–æ–∫–æ –∫–∞—á–µ—Å—Ç–≤–æ –∏ –º–Ω–æ–≥–æ –Ω–∏—Å–∫–æ —Å—ä–æ—Ç–Ω–æ—à–µ–Ω–∏–µ –Ω–∞ „—Å–∏–≥–Ω–∞–ª – —à—É–º”.

–°–ø–æ—Ä–µ–¥ —É—á–µ–Ω–∏—Ç–µ –æ—Å–æ–±–µ–Ω–æ –∏–Ω—Ç–µ—Ä–µ—Å–Ω–∏ —Å–∞ –¥–∞–Ω–Ω–∏—Ç–µ, –ø–æ–ª—É—á–µ–Ω–∏ –æ—Ç –¥–≤–∞ –ø—É–ª—Å–∞—Ä–∞, –æ–±–∏–∫–∞–ª—è—â–∏ –µ–¥–∏–Ω –æ–∫–æ–ª–æ –¥—Ä—É–≥. –¢–∞–∑–∏ –∏–∑–∫–ª—é—á–∏—Ç–µ–ª–Ω–æ —Ä—è–¥–∫–∞ –∫–æ—Å–º–∏—á–µ—Å–∫–∞ –∫–æ–º–±–∏–Ω–∞—Ü–∏—è –≤—Å—ä—â–Ω–æ—Å—Ç –¥–∞–≤–∞ –≤—ä–∑–º–æ–∂–Ω–æ—Å—Ç –¥–∞ –±—ä–¥–∞—Ç –∏–∑—Å–ª–µ–¥–≤–∞–Ω–∏ –µ—Ñ–µ–∫—Ç–∏—Ç–µ –Ω–∞ –æ—Ç–Ω–æ—Å–∏—Ç–µ–ª–Ω–æ—Å—Ç—Ç–∞.

–•–æ–ª–æ—É–µ–π –æ–ø–∏—Å–≤–∞ –ø–æ–¥–æ–±–µ–Ω –µ–∫—Å–ø–µ—Ä–∏–º–µ–Ω—Ç, –ø—Ä–æ–≤–µ–¥–µ–Ω –≤ –∑–µ–º–Ω–∏ —É—Å–ª–æ–≤–∏—è, –ø—Ä–∏ –∫–æ–π—Ç–æ —Å–µ –∑–∞—Å–∏—á–∞ –≤—Ä–µ–º–µ—Ç–æ –ø–æ –¥–≤–∞ —Å–∏–Ω—Ö—Ä–æ–Ω–Ω–æ —Ä–∞–±–æ—Ç–µ—â–∏ –∞—Ç–æ–º–Ω–∏ —á–∞—Å–æ–≤–Ω–∏–∫–∞. –ï–¥–∏–Ω–∏—è—Ç –æ—Ç —Ç—è—Ö —Å–µ –Ω–∞–º–∏—Ä–∞ –Ω–∞ –ø–ª–∞–Ω–µ—Ç–∞—Ç–∞, –∞ –¥—Ä—É–≥–∏—è—Ç –Ω–∞ —Å–∞–º–æ–ª–µ—Ç, –ª–µ—Ç—è—â –æ–∫–æ–ª–æ –ó–µ–º—è—Ç–∞. –í –∫—Ä–∞–π–Ω–∞ —Å–º–µ—Ç–∫–∞ –æ—Ç–º–µ—Ä–µ–Ω–æ—Ç–æ –≤—Ä–µ–º–µ —Å–µ —Ä–∞–∑–ª–∏—á–∞–≤–∞, —Ç—ä–π –∫–∞—Ç–æ –µ–¥–∏–Ω–∏—è—Ç –æ—Ç —á–∞—Å–æ–≤–Ω–∏—Ü–∏—Ç–µ —Å–µ –¥–≤–∏–∂–∏ —Å –æ—Ç–Ω–æ—Å–∏—Ç–µ–ª–Ω–∞ —Å–∫–æ—Ä–æ—Å—Ç —Å–ø—Ä—è–º–æ –¥—Ä—É–≥–∏—è. –Ý–∞–∑–±–∏—Ä–∞ —Å–µ, —Ç–æ–≤–∞ –µ –µ–¥–Ω–æ –¥–æ—Å—Ç–∞ —Å–∫—Ä–æ–º–Ω–æ –∏–∑—Å–ª–µ–¥–≤–∞–Ω–µ –Ω–∞ –ø—Ä–æ—Å–ª–æ–≤—É—Ç–∞—Ç–∞ –¢–µ–æ—Ä–∏—è –Ω–∞ –æ—Ç–Ω–æ—Å–∏—Ç–µ–ª–Ω–æ—Å—Ç—Ç–∞ –Ω–∞ –ê–π–Ω—â–∞–π–Ω, –Ω–æ –∫–æ–≥–∞—Ç–æ —Ç–æ —Å–µ –ø—Ä–æ–≤–µ–∂–¥–∞ –≤ –∫–æ—Å–º–∏—á–µ—Å–∫–∏ –º–∞—â–∞–± (—Å –¥–≤–æ–π–∫–∞ –ø—É–ª—Å–∞—Ä–∏), –Ω–µ—â–∞—Ç–∞ –∑–∞–ø–æ—á–≤–∞—Ç –¥–∞ –∏–∑–≥–ª–µ–∂–¥–∞—Ç –Ω–∞–∏—Å—Ç–∏–Ω–∞ –∏–Ω—Ç–µ—Ä–µ—Å–Ω–∏.

–ü–æ –ø—Ä–∏–Ω—Ü–∏–ø —Ä–∞–¥–∏–æ–∞—Å—Ç—Ä–æ–Ω–æ–º–∏—á–µ—Å–∫–∏—Ç–µ –∏–∑—Å–ª–µ–¥–≤–∞–Ω–∏—è —Å–∞ —Å—Ä–µ–¥ –Ω–∞–π-—Ä–µ—Å—É—Ä—Å–æ–µ–º–∫–∏—Ç–µ –≤ —Ç–∞–∑–∏ —Å—Ñ–µ—Ä–∞. –ò–º–µ–Ω–Ω–æ –ø–æ —Ç–∞–∑–∏ –ø—Ä–∏—á–∏–Ω–∞ –≤—Å–µ–∫–∏ –≥–æ–ª—è–º —Ä–∞–¥–∏–æ—Ç–µ–ª–µ—Å–∫–æ–ø –Ω–∞ –ø–ª–∞–Ω–µ—Ç–∞—Ç–∞ –µ —Å–≤—ä—Ä–∑–∞–Ω —Å –ø–æ–Ω–µ –µ–¥–∏–Ω —Å—É–ø–µ—Ä–∫–æ–º–ø—é—Ç—ä—Ä –æ—Ç —Ä–∞–Ω–≥–∞ –Ω–∞ –•–∏–¥—Ä–∞. –ü–æ–≤–µ—á–µ—Ç–æ –æ—Ç —Ç—è—Ö —Å–∞ –æ—Å–Ω–æ–≤–∞–Ω–∏ –Ω–∞ —Ç–∞–∫–∞ –Ω–∞—Ä–µ—á–µ–Ω–∞—Ç–∞ Blue Gene —Ç–µ—Ö–Ω–æ–ª–æ–≥–∏—è (—Å—ä—â–∞—Ç–∞, –Ω–∞ –∫–æ—è—Ç–æ –µ –±–∞–∑–∏—Ä–∞–Ω –ø—Ä–æ—Å–ª–æ–≤—É—Ç–∏—è—Ç Deep Blue –Ω–∞ IBM), –Ω–æ –∑–∞ –Ω—è–∫–æ–∏ –ø–æ-—Å–ø–µ—Ü–∏—Ñ–∏—á–Ω–∏ –º–∞—Å–∏–≤–∏ –æ—Ç –¥–∞–Ω–Ω–∏ —Ç–µ —Å–µ –æ–∫–∞–∑–≤–∞—Ç –Ω–µ–¥–æ—Å—Ç–∞—Ç—ä—á–Ω–æ –µ—Ñ–µ–∫—Ç–∏–≤–Ω–∏.

–ï–¥–∏–Ω —Ç–∞–∫—ä–≤ –ø—Ä–∏–º–µ—Ä –æ—Ç–∫—Ä–∏–≤–∞–º–µ –≤ —Å—Ñ–µ—Ä–∞—Ç–∞ –Ω–∞ —Ç–∞–∫–∞ –Ω–∞—Ä–µ—á–µ–Ω–∏—Ç–µ Epoch of Reionization –∏–∑—Å–ª–µ–¥–≤–∞–Ω–∏—è (—Å–≤—ä—Ä–∑–∞–Ω–∏ —Å –ø—Ä–æ—É—á–≤–∞–Ω–µ –Ω–∞ –æ–±—Å—Ç–æ—è—Ç–µ–ª—Å—Ç–≤–∞—Ç–∞ –æ–∫–æ–ª–æ –∏ —Å–ª–µ–¥ –ì–æ–ª–µ–º–∏—è –≤–∑—Ä–∏–≤, –≤—Å–ª–µ–¥—Å—Ç–≤–∏–µ –Ω–∞ –∫–æ–π—Ç–æ –µ –≤—ä–∑–Ω–∏–∫–Ω–∞–ª–∞ –í—Å–µ–ª–µ–Ω–∞—Ç–∞).

–°–∞–º–∞—Ç–∞ –º–∞—Ç–µ—Ä–∏—è –µ –¥–æ—Å—Ç–∞ —Å–ª–æ–∂–Ω–∞, –Ω–æ –≤ –æ—Å–Ω–æ–≤–∞—Ç–∞ —Å—Ç–∞–≤–∞ –¥—É–º–∞ –∑–∞ –æ–±—Å–ª–µ–¥–≤–∞–Ω–µ –Ω–∞ –ö–æ—Å–º–æ—Å–∞ –∑–∞ –Ω–∞–ª–∏—á–∏–µ—Ç–æ –Ω–∞ —Å–ø–µ—Ü–∏–∞–ª–Ω–∏ „–¥–∂–æ–±–æ–≤–µ” –æ—Ç –π–æ–Ω–∏–∑–∏—Ä–∞–Ω –≤–æ–¥–æ—Ä–æ–¥, –æ—Å—Ç–∞–Ω–∞–ª–∏ —Å–ª–µ–¥ –µ–∫—Å–ø–ª–æ–∑–∏—è—Ç–∞ —Å –≤—Å–µ–ª–µ–Ω—Å–∫–∏ –ø—Ä–æ–ø–æ—Ä—Ü–∏–∏. –¢—ä–π –∫–∞—Ç–æ –Ω–µ—É—Ç—Ä–∞–ª–Ω–∏—è—Ç –≤–æ–¥–æ—Ä–æ–¥ (–∫–æ–π—Ç–æ –∑–∞–ø—ä–ª–≤–∞ 99% –æ—Ç –∫–æ—Å–º–∏—á–µ—Å–∫–æ—Ç–æ –ø—Ä–æ—Å—Ç—Ä–∞–Ω—Å—Ç–≤–æ) –∏–∑–ª—ä—á–≤–∞ —Å–ø–µ—Ü–∏—Ñ–∏—á–Ω–∞ —Å–ø–µ–∫—Ç—Ä–∞–ª–Ω–∞ –µ–º–∏—Å–∏—è, –∞ –π–æ–Ω–∏–∑–∏—Ä–∞–Ω–∏—è—Ç –≤–æ–¥–æ—Ä–æ–¥ –Ω–µ, –ø–æ—Å—Ä–µ–¥—Å—Ç–≤–æ–º –∞–Ω–∞–ª–∏–∑ –Ω–∞ –¥–∞–Ω–Ω–∏—Ç–µ, –ø–æ–ª—É—á–µ–Ω–∏ –æ—Ç –Ω–∞–±–ª—é–¥–µ–Ω–∏—è —Å —Ä–∞–¥–∏–æ—Ç–µ–ª–µ—Å–∫–æ–ø, –µ –≤—ä–∑–º–æ–∂–Ω–æ –¥–∞ —Å–µ —Ä–µ–≥–∏—Å—Ç—Ä–∏—Ä–∞—Ç –ø–æ–¥–æ–±–Ω–∏ „–º–µ—Ö—É—Ä—á–µ—Ç–∞”, –æ—Å—Ç–∞–Ω–∞–ª–∏ —Å–ª–µ–¥ –ì–æ–ª–µ–º–∏—è –≤–∑—Ä–∏–≤.

–ü—Ä–æ–±–ª–µ–º—ä—Ç –µ, —á–µ –∑–∞–¥–∞—á–∞—Ç–∞, —Å–≤—ä—Ä–∑–∞–Ω–∞ —Å –Ω–∞–º–∏—Ä–∞–Ω–µ—Ç–æ –Ω–∞ —Ç–æ—á–Ω–æ —Ç–µ–∑–∏ –¥–∞–Ω–Ω–∏, –µ –∞–Ω–∞–ª–æ–≥–∏—á–Ω–∞ –Ω–∞ —Ç—ä—Ä—Å–µ–Ω–µ—Ç–æ –Ω–∞ –º–Ω–æ–≥–æ –º–∞–ª–∫–∞ –∏–≥–ª–∞ –≤ –æ–≥—Ä–æ–º–Ω–∞ –∫—É–ø—á–∏–Ω–∞ —Å–µ–Ω–æ. –°–ø–æ—Ä–µ–¥ —É—á–µ–Ω–∏—Ç–µ —Å—Ç–∞–≤–∞ –¥—É–º–∞ –∑–∞ –æ–±—Ä–∞–±–æ—Ç–∫–∞ –Ω–∞ –ø–∞–∫–µ—Ç–∏ –æ—Ç –¥–∞–Ω–Ω–∏ —Å –æ–±–µ–º –æ—Ç 1.5 –ø–µ–Ω—Ç–∞–±–∞–π—Ç–∞ (–æ–∫–æ–ª–æ 1500 —Ç–µ—Ä–∞–±–∞–π—Ç–∞). –ù–∞ —Å—É–ø–µ—Ä–∫–æ–º–ø—é—Ç—ä—Ä —Å –∏–∑—á–∏—Å–ª–∏—Ç–µ–ª–µ–Ω –∫–∞–ø–∞—Ü–∏—Ç–µ—Ç –æ—Ç 100 TFLOPS –ø—Ä–µ—Å—è–≤–∞–Ω–µ—Ç–æ –Ω–∞ –∏–Ω—Ñ–æ—Ä–º–∞—Ü–∏—è —Å –ø–æ–¥–æ–±–µ–Ω –æ–±–º–µ–Ω –±–∏ –æ—Ç–Ω–µ–ª–∞ –≥—Ä—É–±–æ –æ–∫–æ–ª–æ 140 –¥–Ω–∏!

–ò–∑–ø–æ–ª–∑–≤–∞–Ω–µ—Ç–æ –Ω–∞ –º–∞—Å–∏–≤–∏ –æ—Ç –≥—Ä–∞—Ñ–∏—á–Ω–∏ –ø—Ä–æ—Ü–µ—Å–æ—Ä–∏ –≤–º–µ—Å—Ç–æ –ø–æ-—Ç—Ä–∞–¥–∏—Ü–∏–æ–Ω–Ω–∏—Ç–µ Blue Gene –±–∞–∑–∏—Ä–∞–Ω–∏ —Å—É–ø–µ—Ä–∫–æ–º–ø—é—Ç—Ä–∏ –º–æ–∂–µ –¥–∞ —É—Å–∫–æ—Ä–∏ –Ω–µ–∫–æ–ª–∫–æ–∫—Ä–∞—Ç–Ω–æ –æ–±—Ä–∞–±–æ—Ç–∫–∞—Ç–∞ –Ω–∞ –¥–∞–Ω–Ω–∏ –≤ –Ω—è–∫–æ–∏ –æ–±–ª–∞—Å—Ç–∏ –æ—Ç –∫–æ—Å–º–∏—á–µ—Å–∫–∏—Ç–µ –∏–∑—Å–ª–µ–¥–≤–∞–Ω–∏—è.

–ï–¥–∏–Ω –º–ª–∞–¥ —É—á–µ–Ω –Ω–∞ –∏–º–µ –ü–∞–Ω–æ—Å –õ–∞–º–±—Ä–æ–ø–æ–ª—É—Å —Å–º—è—Ç–∞, —á–µ –µ –æ—Ç–∫—Ä–∏–ª –ø–æ-–±—ä—Ä–∑ –Ω–∞—á–∏–Ω –∑–∞ —Ä–µ—à–∞–≤–∞–Ω–µ—Ç–æ –Ω–∞ —Ç–æ–∑–∏ –ø—Ä–æ–±–ª–µ–º. –¢–æ–π –ø—Ä–µ–¥–ª–∞–≥–∞ –≤–º–µ—Å—Ç–æ –∫–ª–∞—Å–∏—á–µ—Å–∫–∏ Blue Gene —Å—É–ø–µ—Ä–∫–æ–º–ø—é—Ç—Ä–∏ –∑–∞ —Ü–µ–ª—Ç–∞ –¥–∞ —Å–µ –∏–∑–ø–æ–ª–∑–≤–∞—Ç –∏–∑—á–∏—Å–ª–∏—Ç–µ–ª–Ω–∏ –º–∞—Å–∏–≤–∏, –±–∞–∑–∏—Ä–∞–Ω–∏ –Ω–∞... –≥—Ä–∞—Ñ–∏—á–Ω–∏ –ø—Ä–æ—Ü–µ—Å–æ—Ä–∏. –ü–æ-–∫–æ–Ω–∫—Ä–µ—Ç–Ω–æ —Å—Ç–∞–≤–∞ –¥—É–º–∞ –∑–∞ 80 –∫–æ–º–ø—é—Ç—ä—Ä–Ω–∏ –≤—ä–∑–µ–ª–∞, –≤—Å–µ–∫–∏ –æ—Ç –∫–æ–∏—Ç–æ –≤–∫–ª—é—á–≤–∞ –ø–æ –¥–≤–µ Nvidia Tesla –∫–∞—Ä—Ç–∏ (–ø—Ä–æ—Ñ–µ—Å–∏–æ–Ω–∞–ª–Ω–∏ –≥—Ä–∞—Ñ–∏—á–Ω–∏ —É—Å–∫–æ—Ä–∏—Ç–µ–ª–∏). –ë–ª–∞–≥–æ–¥–∞—Ä–µ–Ω–∏–µ –Ω–∞ –ø–æ-—Å–ø–µ—Ü–∏—Ñ–∏—á–Ω–∞—Ç–∞ –∞—Ä—Ö–∏—Ç–µ–∫—Ç—É—Ä–∞ –Ω–∞ –≤–∏–¥–µ–æ–ø—Ä–æ—Ü–µ—Å–æ—Ä–∏—Ç–µ –õ–∞–º–±—Ä–æ–ø–æ–ª—É—Å –µ —É—Å–ø—è–ª –¥–∞ –ø–æ—Å—Ç–∏–≥–Ω–µ —É–≤–µ–ª–∏—á–µ–Ω–∏–µ –æ—Ç 5 –¥–æ 12 –ø—ä—Ç–∏ —Å–ø—Ä—è–º–æ —Ç—Ä–∞–¥–∏—Ü–∏–æ–Ω–Ω–∏—Ç–µ —Å—É–ø–µ—Ä–∫–æ–º–ø—é—Ç—ä—Ä–Ω–∏ —Å–∏—Å—Ç–µ–º–∏. –£—á–µ–Ω–∏—è—Ç –µ —É–±–µ–¥–µ–Ω, —á–µ –±–ª–∞–≥–æ–¥–∞—Ä–µ–Ω–∏–µ –Ω–∞ –º–æ—â–Ω–∏—Ç–µ —Å—ä–≤—Ä–µ–º–µ–Ω–Ω–∏ –≥—Ä–∞—Ñ–∏—á–Ω–∏ —á–∏–ø–æ–≤–µ –º–Ω–æ–≥–æ –æ—Ç —Å–ª–æ–∂–Ω–∏—Ç–µ –∞—Å—Ç—Ä–æ–Ω–æ–º–∏—á–µ—Å–∫–∏ –∑–∞–¥–∞—á–∏ –º–æ–≥–∞—Ç –¥–∞ –ø–æ–ª—É—á–∞—Ç —Å–µ—Ä–∏–æ–∑–µ–Ω —Ç–ª–∞—Å—ä–∫ –∏ –¥–∞ –±—ä–¥–∞—Ç —Ä–µ—à–∞–≤–∞–Ω–∏ –¥–æ—Å—Ç–∞ –ø–æ-–±—ä—Ä–∑–æ.